| Autoreninformation |

| Mirko Lindner (Webseite) befasst sich seit 1990 mit Unix. Seit 1998 ist er aktiv in die Entwicklung des Kernels eingebunden und verantwortlich für diverse Treiber und Subsysteme für Linux und andere freie Plattformen. Daneben ist er einer der Betreiber von Pro-Linux.de. |

| Autoreninformation |

| Steffen Rumberger (Webseite) ist Debian GNU/Linux-Nutzer und benutzt auf der Konsole den Editor vi. |

| Autoreninformation |

| Christoph Schmidt ist ein Hobby-Linuxer, welcher unter Verständnislosigkeit seiner Umwelt versucht, möglichst viel seiner privaten IT auf FOSS-Lösungen umzustellen. |

| Autoreninformation |

| Dr. Christoph Zimmermann hatte seinen ersten Kontakt mit Linux vor mehr als zwanzig Jahren im Rahmen seiner Dissertation über reflektive Betriebssysteme. Aktuell ist er im Vorstand der Frankfurter LUG. |

| Buchinformationen | |

| Titel | Doing Math with Python [1] |

| Autor | Amit Saha |

| Verlag | No Starch Press |

| Umfang | 264 Seiten |

| ISBN | 978-1593276409 |

| Preis | 20,95 Euro (Print) |

| Autoreninformation |

| Jochen Schnelle (Webseite) programmiert selber bevorzugt in Python, ist bei seinen Programmierprojekten allerindgs eher selten mit mathematischen Problemen konfrontiert. |

| Buchinformationen | |

| Titel | Gut gerüstet gegen Überwachung im Web – Wie Sie verschlüsselt mailen, chatten und surfen [1] |

| Autor | Christina Czeschik, Matthias Lindhorst, Roswitha Jehle |

| Verlag | Sybex |

| Umfang | 238 Seiten |

| ISBN | 978-3-527-76061-9 |

| Preis | 12,00 Euro (Print), 9,99 Euro (E-Book) |

| Autoreninformation |

| Enrico Wildgrube beschäftigt sich seit drei Jahren mit den Themengebieten Open Source, Linux und Computersicherheit. |

| Buchinformationen | |

| Titel | Coding with JavaScript for Dummies [1] |

| Autor | Eva Holland, Chris Minnick |

| Verlag | Wiley |

| Umfang | 345 Seiten |

| ISBN | 978-1-119-05607-2 |

| Preis | 31,90 Euro (Print), 19,99 Euro (E-Book) |

| Autoreninformation |

| Jochen Schnelle (Webseite) nutzt selber gelegentlich JavaScript für selbstprogrammierte Webanwendungen. |

| Buchinformationen | |

| Titel | Java Web Security [1] |

| Autor | Dominik Schadow |

| Verlag | dpunkt.verlag |

| Umfang | 250 Seiten |

| ISBN | 978-3-86490-146-1 |

| Preis | 32,90 € (Print), 25,99 € (E-Book) |

| Autoreninformation |

| Daniel Myshkin beschäftigt sich seit mehreren Jahren mit den Themengebieten Open Source und Linux und arbeitet als Security Engineer. |

| Messen | ||||

| Veranstaltung | Ort | Datum | Eintritt | Link |

| Global Game Jam | Weltweit | 29.01.–31.01.2016 | frei | http://globalgamejam.org/ |

| FOSDEM | Brüssel | 30.01.–31.01.2016 | – | https://fosdem.org/ |

| Hack Im Pott | Essen | 26.02.2016 | 13,37 EUR | https://events.ccc.de/congress/2015 |

| Chemnitzer Linux-Tage | Chemnitz | 19.03.–20.03.2016 | – | http://chemnitzer.linux-tage.de/ |

| Easterhegg | Salzburg | 25.03.–28.03.2016 | 42 EUR | https://eh16.easterhegg.eu/ |

| $: | Shell-Prompt |

| #: | Prompt einer Root-Shell – Ubuntu-Nutzer können hier auch einfach in einer normalen Shell ein sudo vor die Befehle setzen. |

| ~: | Abkürzung für das eigene Benutzerverzeichnis /home/BENUTZERNAME |

| Android Google-frei konfigurieren und Alternativen einrichten | 04/2015 |

| Rezension: Apps entwickeln mit Android Studio – Video Training | 05/2015 |

| Rezension: NFC mit Android und Arduino | 09/2015 |

| Rezension: Das Arduino-Training – Sehen wie's geht! | 08/2015 |

| Rezension: NFC mit Android und Arduino | 09/2015 |

| Rezension: Roboter bauen mit Arduino | 03/2015 |

| OpenBSD – Einmal Kugelfisch, bitte. | 09/2015 |

| Bildbearbeitung mit GIMP – Teil 1: Bildteile entfernen | 01/2015 |

| Bildbearbeitung mit GIMP – Teil 2: Helligkeit und Kontrast anpassen | 02/2015 |

| Bildbearbeitung mit GIMP – Teil 3: Das Wichtigste zu den Ebenen | 03/2015 |

| Kurztipp: Hintergrund einer Blaupause mit GIMP | 02/2015 |

| Kurzvorstellung: renrot – Hilfsmittel für Bilder | 06/2015 |

| Privacy Guide – Anleitung zur Wahrung der Privatsphäre im Internet | 03/2015 |

| Calibre – Teil 1: Installation und Erst-Konfiguration | 01/2015 |

| Rezension: Adventures in Python | 08/2015 |

| Rezension: Apps entwickeln mit Android Studio – Video Training | 05/2015 |

| Rezension: C Programming in Easy Steps | 05/2015 |

| Rezension: Das Sketchnote-Handbuch | 09/2015 |

| Rezension: Einführung in Mathematica | 02/2015 |

| Rezension: Entwurfsmuster von Kopf bis Fuß | 11/2015 |

| Rezension: Entwurfsmuster – Das umfassende Handbuch | 10/2015 |

| Rezension: Git – Verteilte Versionsverwaltung für Code und Dokumente | 07/2015 |

| Rezension: Grundkurs Programmieren in Java | 06/2015 |

| Rezension: Ha3k3ln+Str1ck3n für Geeks | 10/2015 |

| Rezension: Hello World! Programmieren für Kids und andere Anfänger | 04/2015 |

| Rezension: Let's Play Minecraft: Dein Praxis-Guide | 07/2015 |

| Rezension: Let's Play Minecraft: Dein Redstone-Guide | 11/2015 |

| Rezension: Linux – Das umfassende Handbuch | 06/2015 |

| Rezension: Linux-Server für Einsteiger | 05/2015 |

| Rezension: Meteor | 09/2015 |

| Rezension: NFC mit Android und Arduino | 09/2015 |

| Rezension: Network Hacking | 04/2015 |

| Rezension: PHP 5.6 und MySQL | 09/2015 |

| Rezension: Praxisbuch Ubuntu Server 14.04 LTS | 02/2015 |

| Rezension: Professionell entwickeln mit JavaScript | 10/2015 |

| Rezension: Programmieren lernen mit Python | 01/2015 |

| Rezension: Python 3 – Das umfassende Handbuch | 10/2015 |

| Rezension: Python GE-PACKT | 09/2015 |

| Rezension: Python – kurz & gut | 02/2015 |

| Rezension: Raspberry Pi Kochbuch | 04/2015 |

| Rezension: Raspberry Pi für Kids | 03/2015 |

| Rezension: Roboter bauen mit Arduino | 03/2015 |

| Rezension: Seven More Languages in Seven Weeks | 12/2015 |

| Rezension: Software Testing – Concepts and Operations | 11/2015 |

| Rezension: Software-Dokumentation mit Sphinx | 11/2015 |

| Rezension: The Art of Unit Testing | 07/2015 |

| Rezension: Ubuntu 14.04 für Ein- und Umsteiger | 03/2015 |

| Rezension: Vorgehensmuster für Software-Architektur | 05/2015 |

| Rezension: What if? Was wäre wenn? | 06/2015 |

| Rezension: Wireshark 101 - Einführung in die Protokollanalyse | 01/2015 |

| Rezension: jQuery in Easy Steps | 08/2015 |

| Gesundheit am PC | 05/2015 |

| Impress.js-basierte Präsentationen mit Hovercraft | 05/2015 |

| MegaFont NEXT – Schriften auch für Linux | 12/2015 |

| Eine Geschichte von Linux | 11/2015 |

| Ende des siebten Programmierwettbewerbs | 02/2015 |

| Rückblick: DANTE-Frühjahrstagung 2015 in Stralsund | 06/2015 |

| Ubucon 2015 – Willkommen zurück in Berlin! | 12/2015 |

| Meine Daten gehören mir! | 06/2015 |

| Calibre – Teil 1: Installation und Erst-Konfiguration | 01/2015 |

| Batterien enthalten: Linux Mint Debian Edition (LMDE) | 03/2015 |

| Debian GNU/Linux 8.0 „Jessie“ | 07/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| Batterien enthalten: Linux Mint Debian Edition (LMDE) | 03/2015 |

| Debian GNU/Linux 8.0 „Jessie“ | 07/2015 |

| Fedora 21 | 02/2015 |

| Fedora 22 | 09/2015 |

| Firefox OS 2.5 – Update des Mozilla Flame | 10/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| OpenBSD – Einmal Kugelfisch, bitte. | 09/2015 |

| Projektvorstellung: Distrochooser | 09/2015 |

| Ubuntu und Kubuntu 15.04 | 06/2015 |

| Ubuntu und Kubuntu 15.10 | 12/2015 |

| Rezension: Software-Dokumentation mit Sphinx | 11/2015 |

| Privacy Guide – Anleitung zur Wahrung der Privatsphäre im Internet | 03/2015 |

| Fedora 21 | 02/2015 |

| Fedora 22 | 09/2015 |

| Firefox OS 2.5 – Update des Mozilla Flame | 10/2015 |

| Fuchs in Flammen: Mozilla Flame im Test | 01/2015 |

| Privacy Guide – Anleitung zur Wahrung der Privatsphäre im Internet | 03/2015 |

| Android Google-frei konfigurieren und Alternativen einrichten | 04/2015 |

| Dynam. Dashboards mit AngularJS, D3.js und OpenCPU | 03/2015 |

| Eine Geschichte von Linux | 11/2015 |

| Einführung in LilyPond 2.18.2 | 04/2015 |

| Einführung in LilyPond 2.18.2 | 05/2015 |

| Gesundheit am PC | 05/2015 |

| Labdoo: Ausgediente Laptops mit Linux für Bildungseinrichtungen | 10/2015 |

| Projektvorstellung: Distrochooser | 09/2015 |

| ShareLaTeX | 03/2015 |

| WPS Office im Test | 11/2015 |

| Bildbearbeitung mit GIMP – Teil 1: Bildteile entfernen | 01/2015 |

| Bildbearbeitung mit GIMP – Teil 2: Helligkeit und Kontrast anpassen | 02/2015 |

| Bildbearbeitung mit GIMP – Teil 3: Das Wichtigste zu den Ebenen | 03/2015 |

| Kurztipp: Hintergrund einer Blaupause mit GIMP | 02/2015 |

| Git-Tutorium – Teil 4: GitHub | 06/2015 |

| Android Google-frei konfigurieren und Alternativen einrichten | 04/2015 |

| Eine kurze Einführung in gnuplot | 08/2015 |

| Kurzvorstellung: renrot – Hilfsmittel für Bilder | 06/2015 |

| Mit LaTeX zum E-Book | 07/2015 |

| Firefox OS 2.5 – Update des Mozilla Flame | 10/2015 |

| Fuchs in Flammen: Mozilla Flame im Test | 01/2015 |

| Labdoo: Ausgediente Laptops mit Linux für Bildungseinrichtungen | 10/2015 |

| Review: bq Aquaris E5 – Ubuntu Edition | 09/2015 |

| Rezension: Ha3k3ln+Str1ck3n für Geeks | 10/2015 |

| Rezension: NFC mit Android und Arduino | 09/2015 |

| Ubuntu Phone: Das Meizu MX4 näher angeschaut | 08/2015 |

| Ubuntu Phone: Das bq Aquaris E4.5 näher angeschaut | 04/2015 |

| I2P unter Ubuntu auf dem Raspberry Pi 2 installieren | 11/2015 |

| Meine Daten gehören mir! | 06/2015 |

| ShareLaTeX | 03/2015 |

| Thruk – Besser überwachen | 12/2015 |

| Tiny Tiny RSS – Ein web-basierter Feed-Aggregator | 01/2015 |

| Rezension: Entwurfsmuster von Kopf bis Fuß | 11/2015 |

| Rezension: Grundkurs Programmieren in Java | 06/2015 |

| Dynam. Dashboards mit AngularJS, D3.js und OpenCPU | 03/2015 |

| Impress.js-basierte Präsentationen mit Hovercraft | 05/2015 |

| Rezension: Meteor | 09/2015 |

| Rezension: Professionell entwickeln mit JavaScript | 10/2015 |

| Rezension: jQuery in Easy Steps | 08/2015 |

| Ubuntu und Kubuntu 15.04 | 06/2015 |

| Ubuntu und Kubuntu 15.10 | 12/2015 |

| Der April im Kernelrückblick | 05/2015 |

| Der August im Kernelrückblick | 09/2015 |

| Der Dezember im Kernelrückblick | 01/2015 |

| Der Februar im Kernelrückblick | 03/2015 |

| Der Januar im Kernelrückblick | 02/2015 |

| Der Juli im Kernelrückblick | 08/2015 |

| Der Juni im Kernelrückblick | 07/2015 |

| Der Mai im Kernelrückblick | 06/2015 |

| Der März im Kernelrückblick | 04/2015 |

| Der November im Kernelrückblick | 12/2015 |

| Der Oktober im Kernelrückblick | 11/2015 |

| Der September im Kernelrückblick | 10/2015 |

| Rezension: Einführung in Mathematica | 02/2015 |

| Spiele-Vorstellung aus dem Humble PC & Android Bundle 13 | 09/2015 |

| The Book of Unwritten Tales 2 | 06/2015 |

| To The Moon – Reise zum Mond | 03/2015 |

| Kurztipp: tmux mit Byobu nutzen | 01/2015 |

| Kurzvorstellung: renrot – Hilfsmittel für Bilder | 06/2015 |

| Ubuntu und Kubuntu 15.04 | 06/2015 |

| Ubuntu und Kubuntu 15.10 | 12/2015 |

| Mit LaTeX zum E-Book | 07/2015 |

| Modifizieren eines Biblatex-Stils | 08/2015 |

| Rückblick: DANTE-Frühjahrstagung 2015 in Stralsund | 06/2015 |

| ShareLaTeX | 03/2015 |

| TeXmacs als Präsentationstool nutzen | 08/2015 |

| Eine Geschichte von Linux | 11/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| Projektvorstellung: Distrochooser | 09/2015 |

| Proprietär vs. Open Source – Die ewige Debatte um die Sicherheit | 10/2015 |

| Rezension: Linux – Das umfassende Handbuch | 06/2015 |

| Web Scraping mit R | 08/2015 |

| cut out selected fields of each line of a file | 07/2015 |

| Ende des siebten Programmierwettbewerbs | 02/2015 |

| Mit LaTeX zum E-Book | 07/2015 |

| Calibre – Teil 1: Installation und Erst-Konfiguration | 01/2015 |

| Firefox OS 2.5 – Update des Mozilla Flame | 10/2015 |

| Fuchs in Flammen: Mozilla Flame im Test | 01/2015 |

| Firefox OS 2.5 – Update des Mozilla Flame | 10/2015 |

| Fuchs in Flammen: Mozilla Flame im Test | 01/2015 |

| Einführung in LilyPond 2.18.2 | 04/2015 |

| Einführung in LilyPond 2.18.2 | 05/2015 |

| I2P unter Ubuntu auf dem Raspberry Pi 2 installieren | 11/2015 |

| Rezension: Network Hacking | 04/2015 |

| Rezension: Wireshark 101 - Einführung in die Protokollanalyse | 01/2015 |

| Spacewalk – Teil 4: Verwaltung von Solaris-Systemen | 01/2015 |

| Spacewalk – Teil 5: Troubleshooting und Zukunft | 03/2015 |

| Suricata: Einbruchserkennung mit dem Erdmännchen | 02/2015 |

| Thruk – Besser überwachen | 12/2015 |

| MegaFont NEXT – Schriften auch für Linux | 12/2015 |

| WPS Office im Test | 11/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| Rezension: PHP 5.6 und MySQL | 09/2015 |

| Dynam. Dashboards mit AngularJS, D3.js und OpenCPU | 03/2015 |

| Ende des siebten Programmierwettbewerbs | 02/2015 |

| Git Tutorium – Teil 2 | 01/2015 |

| Git Tutorium – Teil 3 | 02/2015 |

| Git-Tutorium – Teil 4: GitHub | 06/2015 |

| Neues in Octave 4.0.0 | 07/2015 |

| Octave – Teil 2: Funktionen, Graphen und komplexe Zahlen | 02/2015 |

| Octave – Teil 3: Numerische Integration und Matrizen | 04/2015 |

| Rezension: Apps entwickeln mit Android Studio – Video Training | 05/2015 |

| Rezension: C Programming in Easy Steps | 05/2015 |

| Rezension: Entwurfsmuster von Kopf bis Fuß | 11/2015 |

| Rezension: Entwurfsmuster – Das umfassende Handbuch | 10/2015 |

| Rezension: Grundkurs Programmieren in Java | 06/2015 |

| Rezension: Hello World! Programmieren für Kids und andere Anfänger | 04/2015 |

| Rezension: Professionell entwickeln mit JavaScript | 10/2015 |

| Rezension: Programmieren lernen mit Python | 01/2015 |

| Rezension: Seven More Languages in Seven Weeks | 12/2015 |

| Rezension: Software Testing – Concepts and Operations | 11/2015 |

| Rezension: The Art of Unit Testing | 07/2015 |

| Rezension: Vorgehensmuster für Software-Architektur | 05/2015 |

| Shell Command Injection – Wie fremder Text in das Terminal gelangt | 10/2015 |

| Einführung in LilyPond 2.18.2 | 04/2015 |

| Impress.js-basierte Präsentationen mit Hovercraft | 05/2015 |

| TeXmacs als Präsentationstool nutzen | 08/2015 |

| Rezension: Adventures in Python | 08/2015 |

| Rezension: Hello World! Programmieren für Kids und andere Anfänger | 04/2015 |

| Rezension: Programmieren lernen mit Python | 01/2015 |

| Rezension: Programmieren lernen mit Python | 12/2015 |

| Rezension: Python 3 – Das umfassende Handbuch | 10/2015 |

| Rezension: Python GE-PACKT | 09/2015 |

| Rezension: Python – kurz & gut | 02/2015 |

| Shell Command Injection – Wie fremder Text in das Terminal gelangt | 10/2015 |

| Tiny Tiny RSS – Ein web-basierter Feed-Aggregator | 01/2015 |

| I2P unter Ubuntu auf dem Raspberry Pi 2 installieren | 11/2015 |

| Rezension: Raspberry Pi Kochbuch | 04/2015 |

| Rezension: Raspberry Pi für Kids | 03/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| Rezension: Adventures in Python | 08/2015 |

| Rezension: Apps entwickeln mit Android Studio – Video Training | 05/2015 |

| Rezension: C Programming in Easy Steps | 05/2015 |

| Rezension: Das Arduino-Training – Sehen wie's geht! | 08/2015 |

| Rezension: Das Sketchnote-Handbuch | 09/2015 |

| Rezension: Einführung in Mathematica | 02/2015 |

| Rezension: Entwurfsmuster von Kopf bis Fuß | 11/2015 |

| Rezension: Entwurfsmuster – Das umfassende Handbuch | 10/2015 |

| Rezension: Git – Verteilte Versionsverwaltung für Code und Dokumente | 07/2015 |

| Rezension: Grundkurs Programmieren in Java | 06/2015 |

| Rezension: Ha3k3ln+Str1ck3n für Geeks | 10/2015 |

| Rezension: Hello World! Programmieren für Kids und andere Anfänger | 04/2015 |

| Rezension: Let's Play Minecraft: Dein Praxis-Guide | 07/2015 |

| Rezension: Let's Play Minecraft: Dein Redstone-Guide | 11/2015 |

| Rezension: Linux – Das umfassende Handbuch | 06/2015 |

| Rezension: Linux-Server für Einsteiger | 05/2015 |

| Rezension: Meteor | 09/2015 |

| Rezension: NFC mit Android und Arduino | 09/2015 |

| Rezension: Network Hacking | 04/2015 |

| Rezension: PHP 5.6 und MySQL | 09/2015 |

| Rezension: Praxisbuch Ubuntu Server 14.04 LTS | 02/2015 |

| Rezension: Professionell entwickeln mit JavaScript | 10/2015 |

| Rezension: Programmieren lernen mit Python | 01/2015 |

| Rezension: Programmieren lernen mit Python | 12/2015 |

| Rezension: Python 3 – Das umfassende Handbuch | 10/2015 |

| Rezension: Python GE-PACKT | 09/2015 |

| Rezension: Python – kurz & gut | 02/2015 |

| Rezension: Raspberry Pi Kochbuch | 04/2015 |

| Rezension: Raspberry Pi für Kids | 03/2015 |

| Rezension: Roboter bauen mit Arduino | 03/2015 |

| Rezension: Seven More Languages in Seven Weeks | 12/2015 |

| Rezension: Software Testing – Concepts and Operations | 11/2015 |

| Rezension: Software-Dokumentation mit Sphinx | 11/2015 |

| Rezension: The Art of Unit Testing | 07/2015 |

| Rezension: Ubuntu 14.04 für Ein- und Umsteiger | 03/2015 |

| Rezension: Vorgehensmuster für Software-Architektur | 05/2015 |

| Rezension: What if? Was wäre wenn? | 06/2015 |

| Rezension: Wireshark 101 - Einführung in die Protokollanalyse | 01/2015 |

| Rezension: jQuery in Easy Steps | 08/2015 |

| Rezension: Linux-Server für Einsteiger | 05/2015 |

| Rezension: Praxisbuch Ubuntu Server 14.04 LTS | 02/2015 |

| Thruk – Besser überwachen | 12/2015 |

| Tiny Tiny RSS – Ein web-basierter Feed-Aggregator | 01/2015 |

| I2P unter Ubuntu auf dem Raspberry Pi 2 installieren | 11/2015 |

| Meine Daten gehören mir! | 06/2015 |

| Privacy Guide – Anleitung zur Wahrung der Privatsphäre im Internet | 03/2015 |

| Proprietär vs. Open Source – Die ewige Debatte um die Sicherheit | 10/2015 |

| Rezension: Network Hacking | 04/2015 |

| Rezension: Wireshark 101 - Einführung in die Protokollanalyse | 01/2015 |

| Shell Command Injection – Wie fremder Text in das Terminal gelangt | 10/2015 |

| Thruk – Besser überwachen | 12/2015 |

| Rezension: Let's Play Minecraft: Dein Praxis-Guide | 07/2015 |

| Rezension: Let's Play Minecraft: Dein Redstone-Guide | 11/2015 |

| Spiele-Kurzvorstellung aus dem Humble PC & Android Bundle 13 | 09/2015 |

| The Book of Unwritten Tales 2 | 06/2015 |

| To The Moon – Reise zum Mond | 03/2015 |

| Das Konsolentool top | 08/2015 |

| Spacewalk – Teil 4: Verwaltung von Solaris-Systemen | 01/2015 |

| Spacewalk – Teil 5: Troubleshooting und Zukunft | 03/2015 |

| Suricata: Einbruchserkennung mit dem Erdmännchen | 02/2015 |

| Das Konsolentool top | 08/2015 |

| Spacewalk – Teil 4: Verwaltung von Solaris-Systemen | 01/2015 |

| Spacewalk – Teil 5: Troubleshooting und Zukunft | 03/2015 |

| Suricata: Einbruchserkennung mit dem Erdmännchen | 02/2015 |

| Thruk – Besser überwachen | 12/2015 |

| Gesundheit am PC | 05/2015 |

| Kurztipp: Hintergrund einer Blaupause mit GIMP | 02/2015 |

| Kurztipp: tmux mit Byobu nutzen | 01/2015 |

| Kurzvorstellung: renrot – Hilfsmittel für Bilder | 06/2015 |

| TeXmacs als Präsentationstool nutzen | 08/2015 |

| Web Scraping mit R | 08/2015 |

| cut out selected fields of each line of a file | 07/2015 |

| Batterien enthalten: Linux Mint Debian Edition (LMDE) | 03/2015 |

| I2P unter Ubuntu auf dem Raspberry Pi 2 installieren | 11/2015 |

| Linux-Distributionen mit Langzeitunterstützung (LTS) | 07/2015 |

| Review: bq Aquaris E5 – Ubuntu Edition | 09/2015 |

| Rezension: Praxisbuch Ubuntu Server 14.04 LTS | 02/2015 |

| Rezension: Ubuntu 14.04 für Ein- und Umsteiger | 03/2015 |

| Ubucon 2015 – Willkommen zurück in Berlin! | 12/2015 |

| Ubuntu Phone: Das Meizu MX4 näher angeschaut | 08/2015 |

| Ubuntu Phone: Das bq Aquaris E4.5 näher angeschaut | 04/2015 |

| Ubuntu und Kubuntu 15.04 | 06/2015 |

| Ubuntu und Kubuntu 15.10 | 12/2015 |

| Ubucon 2015 – Willkommen zurück in Berlin! | 12/2015 |

| Privacy Guide – Anleitung zur Wahrung der Privatsphäre im Internet | 03/2015 |

| Git Tutorium – Teil 2 | 01/2015 |

| Git Tutorium – Teil 3 | 02/2015 |

| Git-Tutorium – Teil 4: GitHub | 06/2015 |

| Rezension: Git – Verteilte Versionsverwaltung für Code und Dokumente | 07/2015 |

| Rezension: Das Arduino-Training – Sehen wie's geht! | 08/2015 |

| Rezension: Programmieren lernen mit Python | 12/2015 |

| Ende des siebten Programmierwettbewerbs | 02/2015 |

| Eine kurze Einführung in gnuplot | 08/2015 |

| Labdoo: Ausgediente Laptops mit Linux für Bildungseinrichtungen | 10/2015 |

| Neues in Octave 4.0.0 | 07/2015 |

| Octave – Teil 2: Funktionen, Graphen und komplexe Zahlen | 02/2015 |

| Octave – Teil 3: Numerische Integration und Matrizen | 04/2015 |

| WPS Office im Test | 11/2015 |

| Kontakt | |

| Postanschrift | freiesMagazin |

| c/o Dominik Wagenführ | |

| Beethovenstr. 9/1 | |

| 71277 Rutesheim | |

| Webpräsenz | http://www.freiesmagazin.de/ |

| Autoren dieser Ausgabe | |

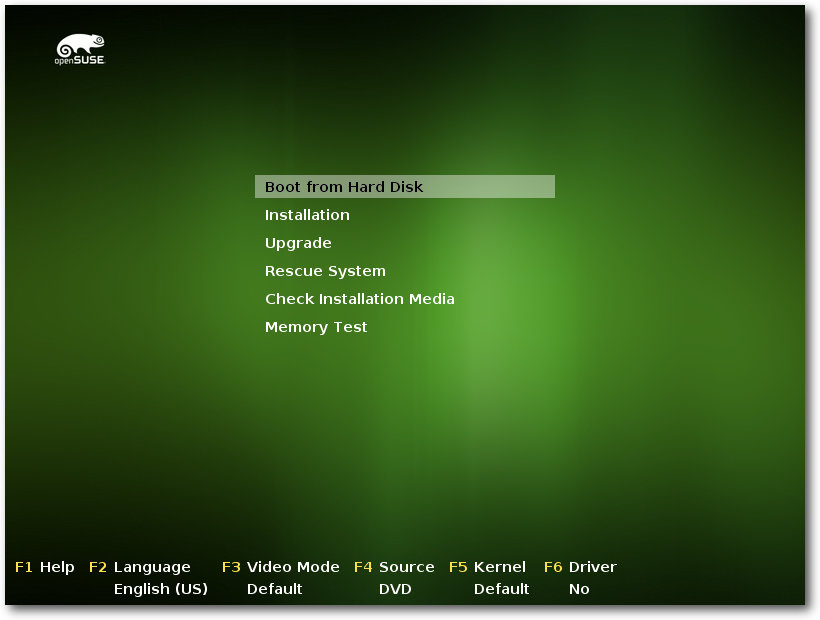

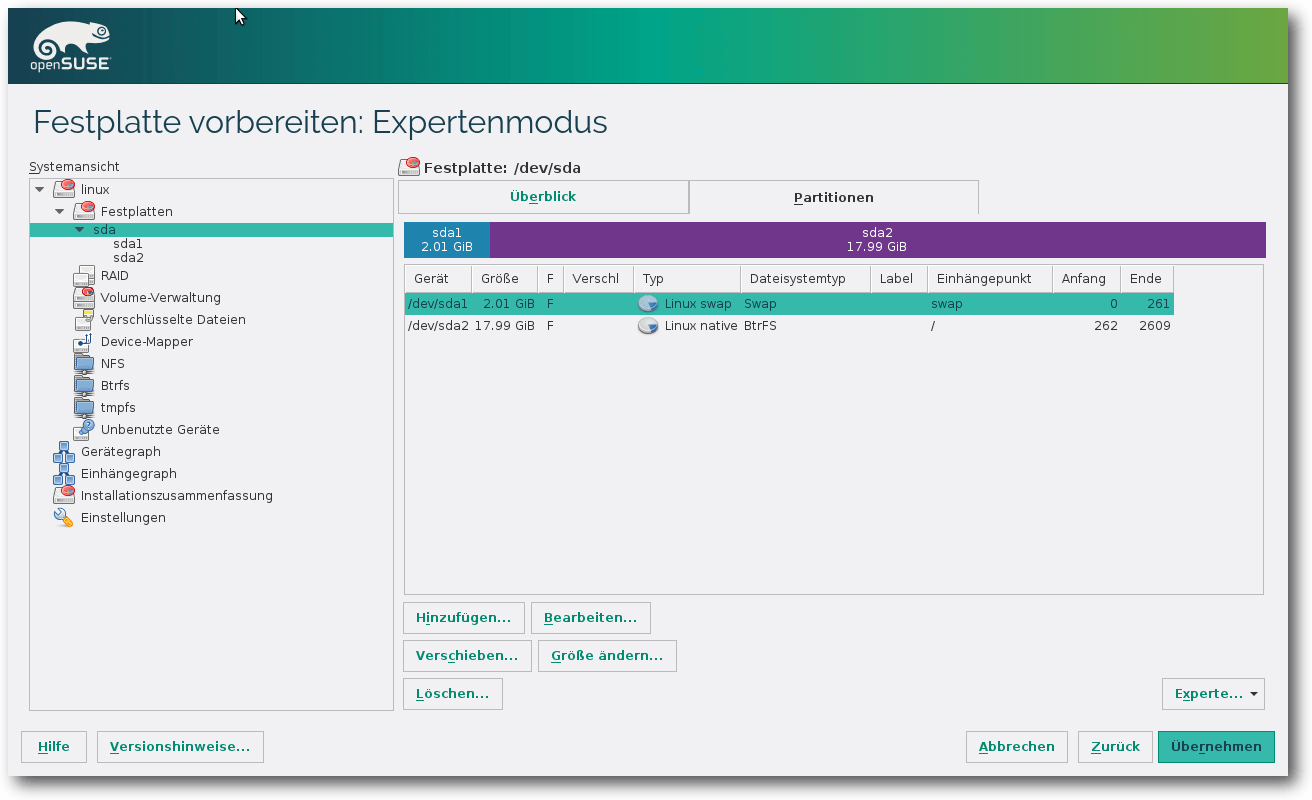

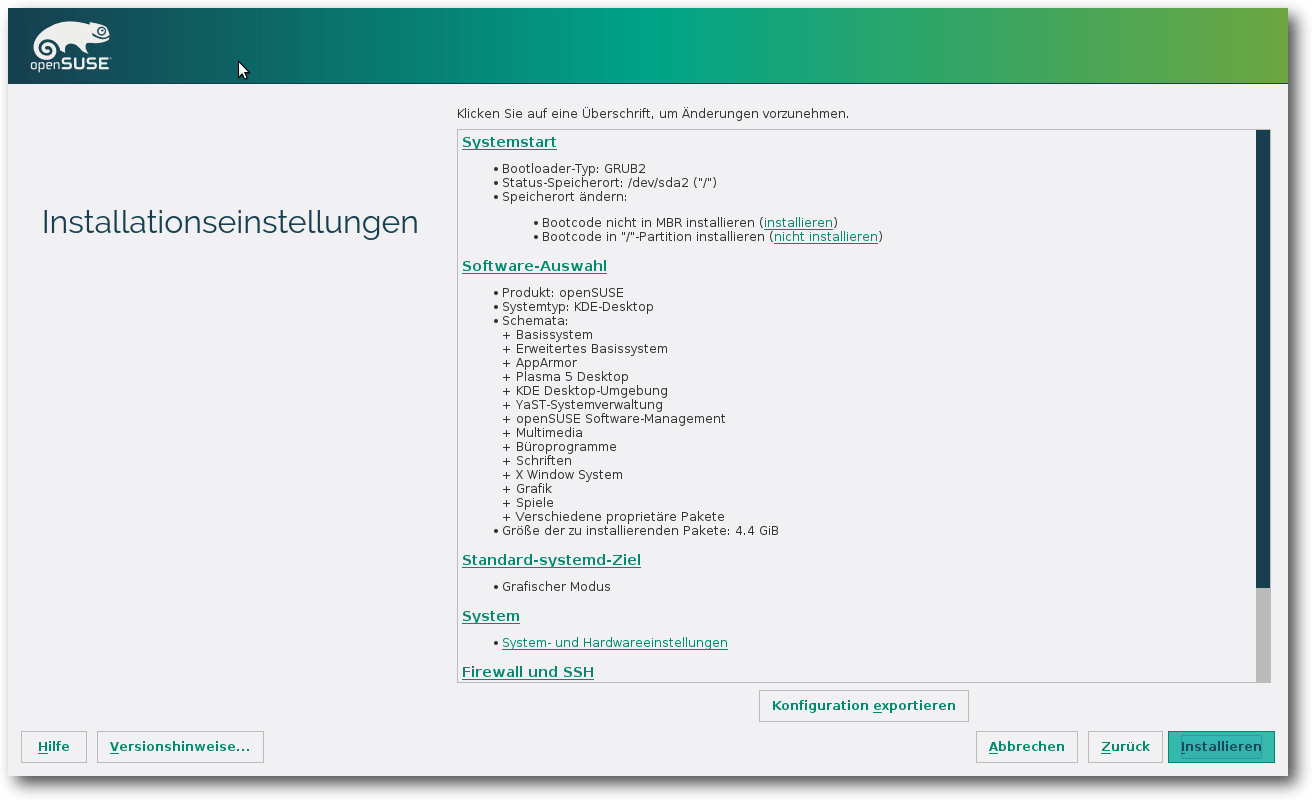

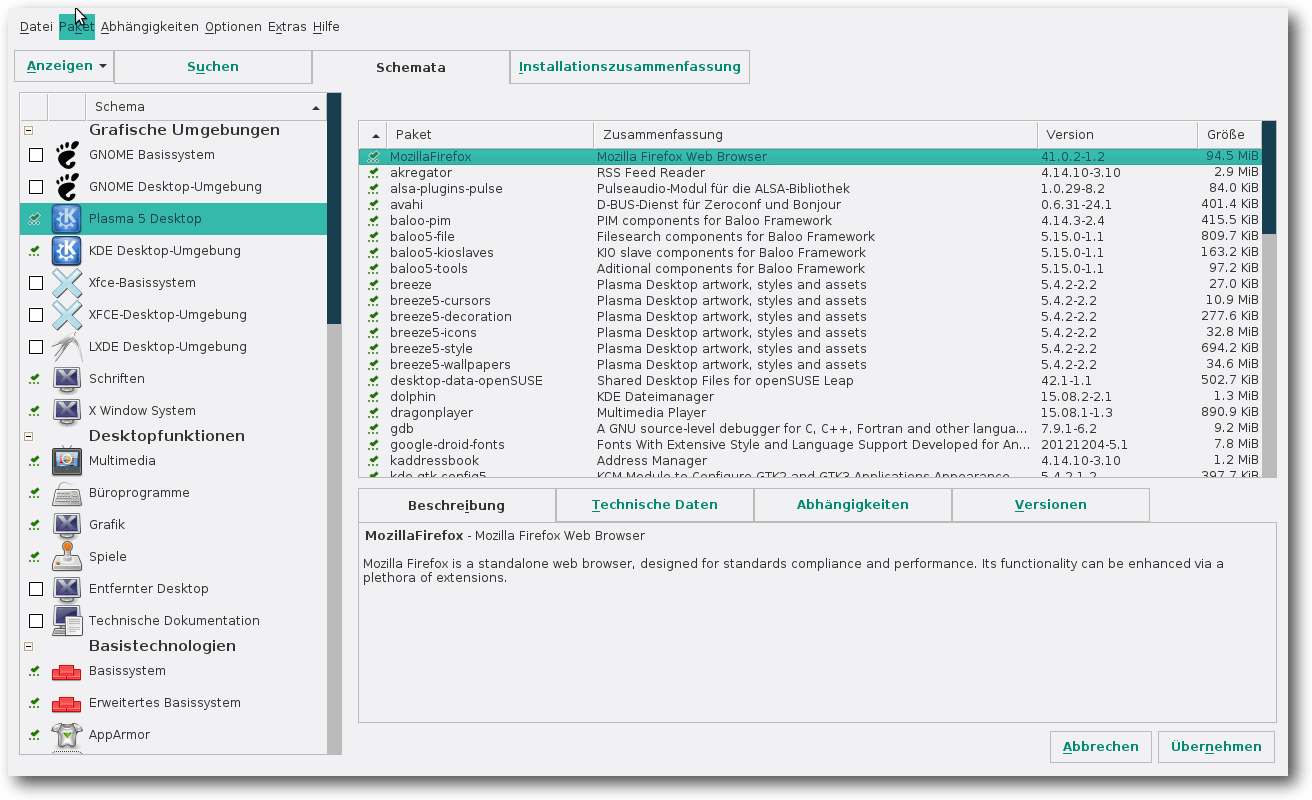

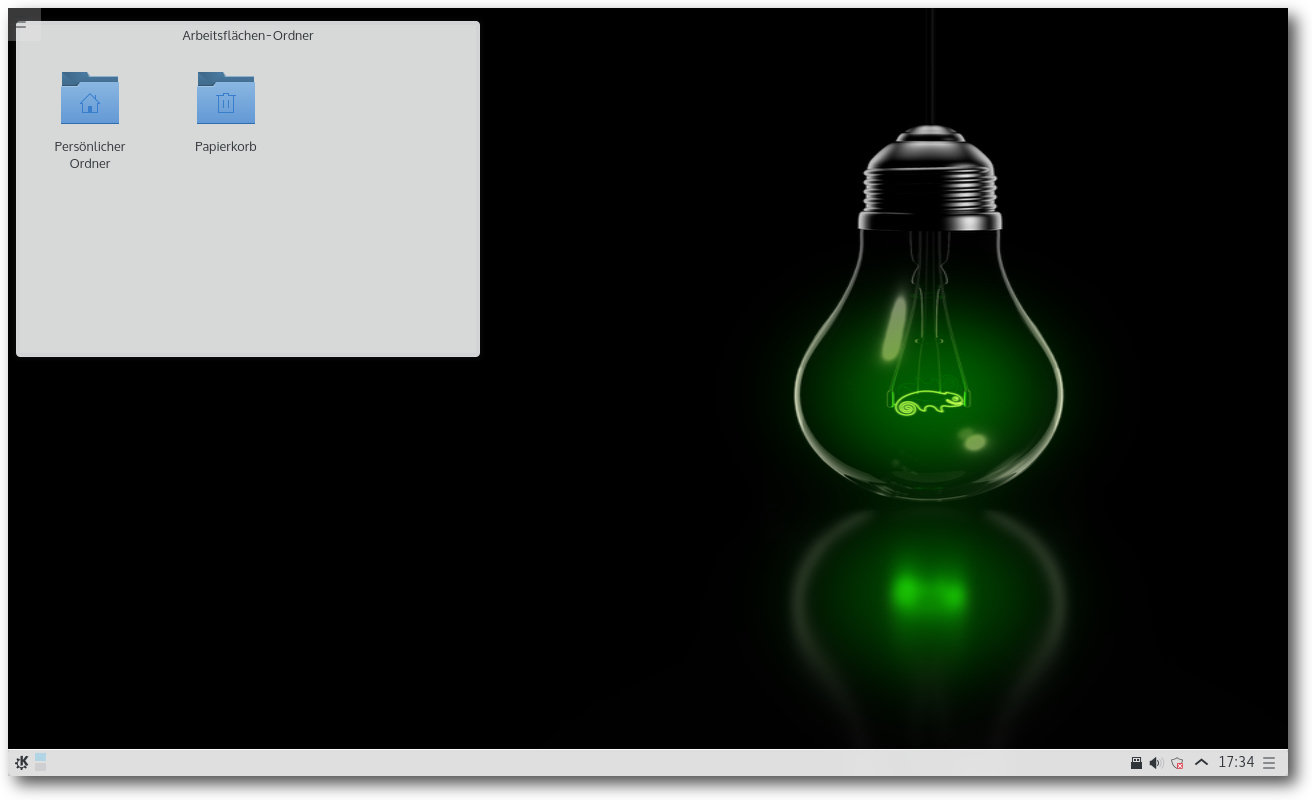

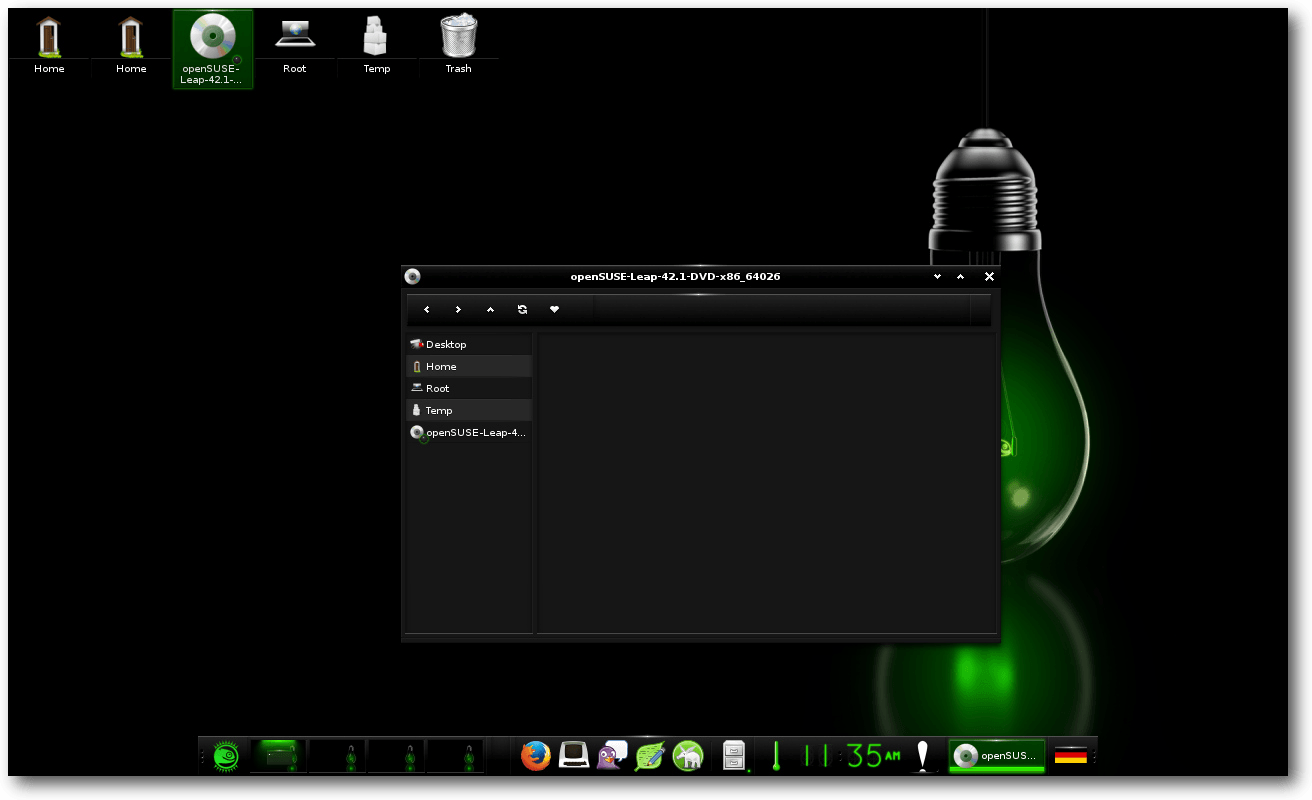

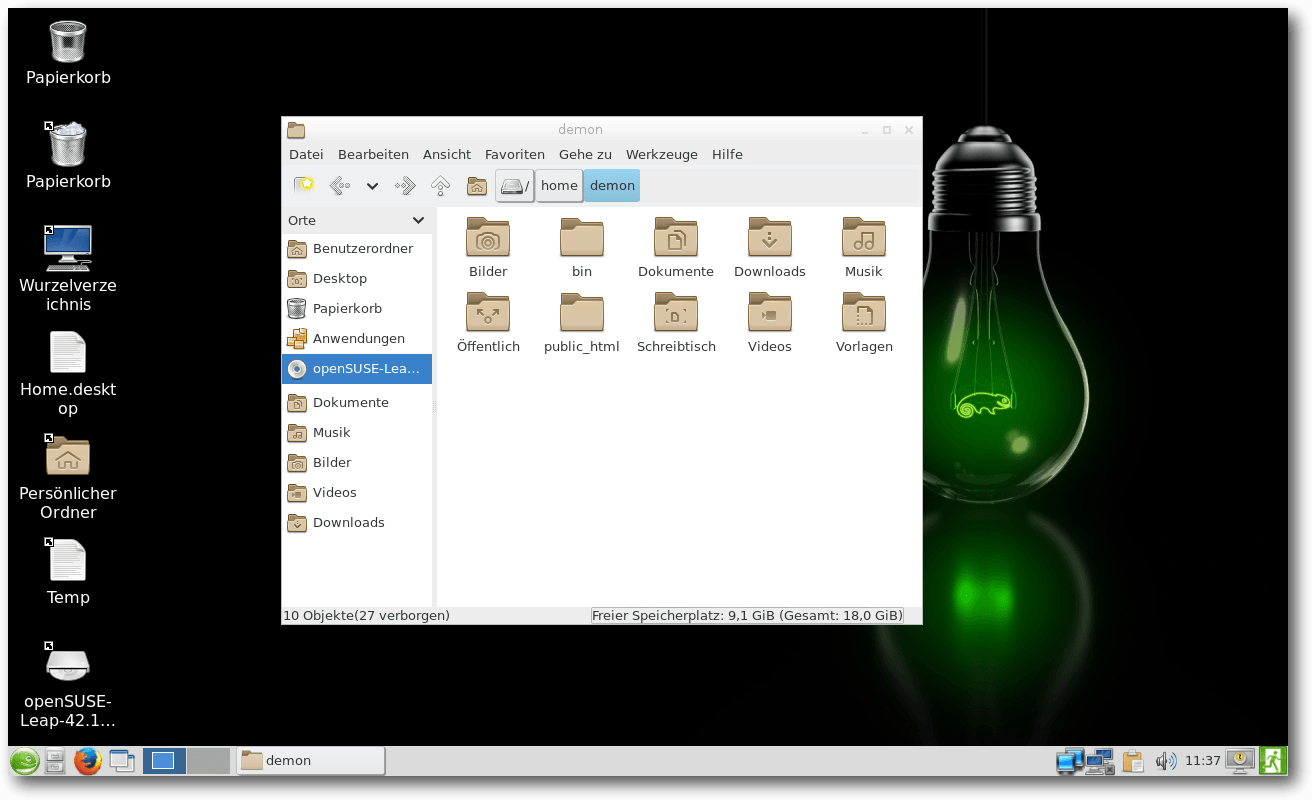

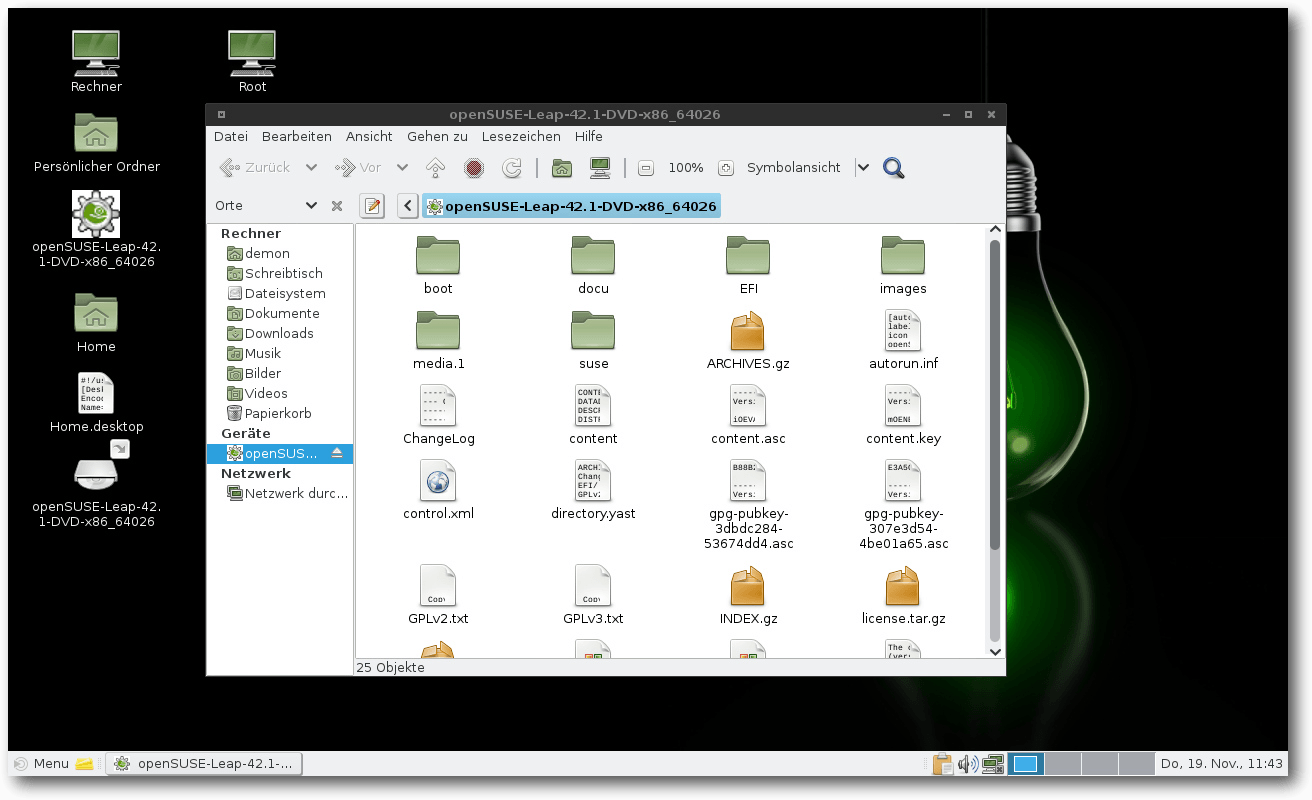

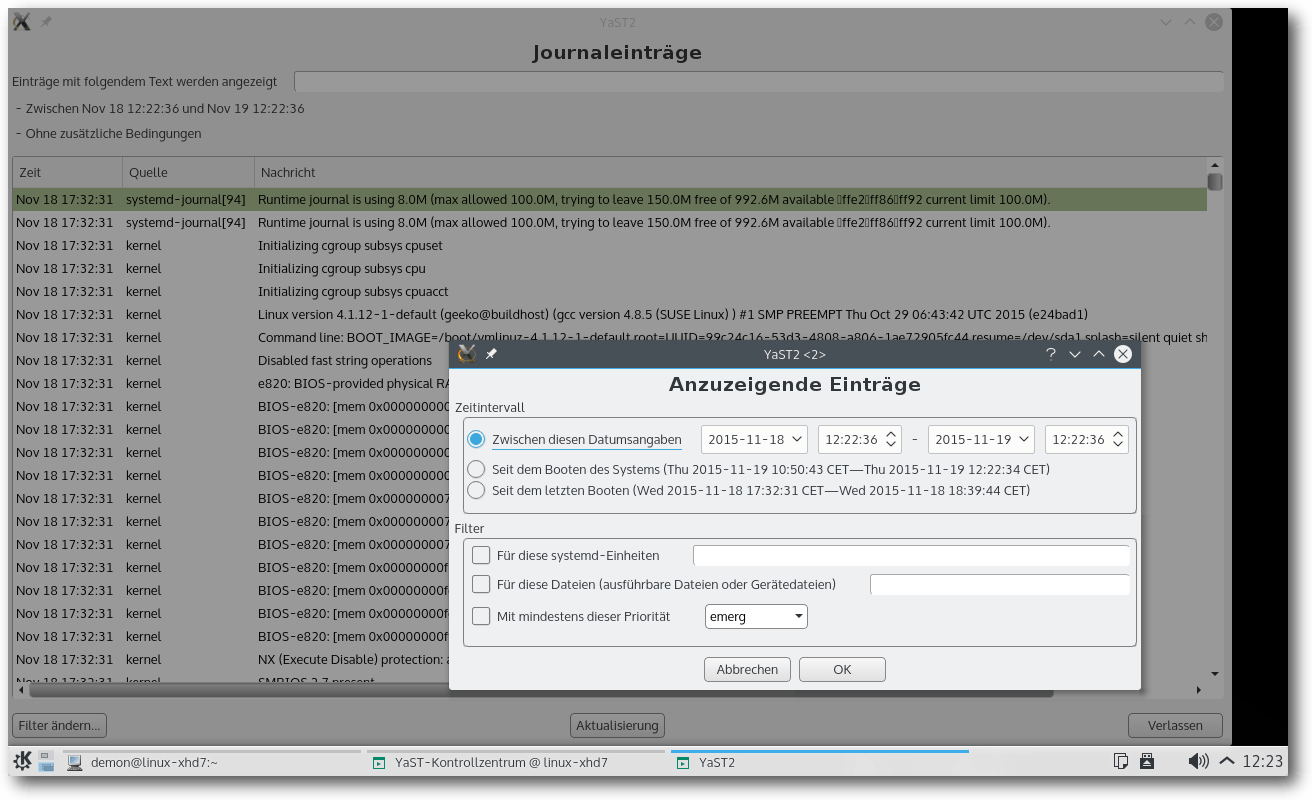

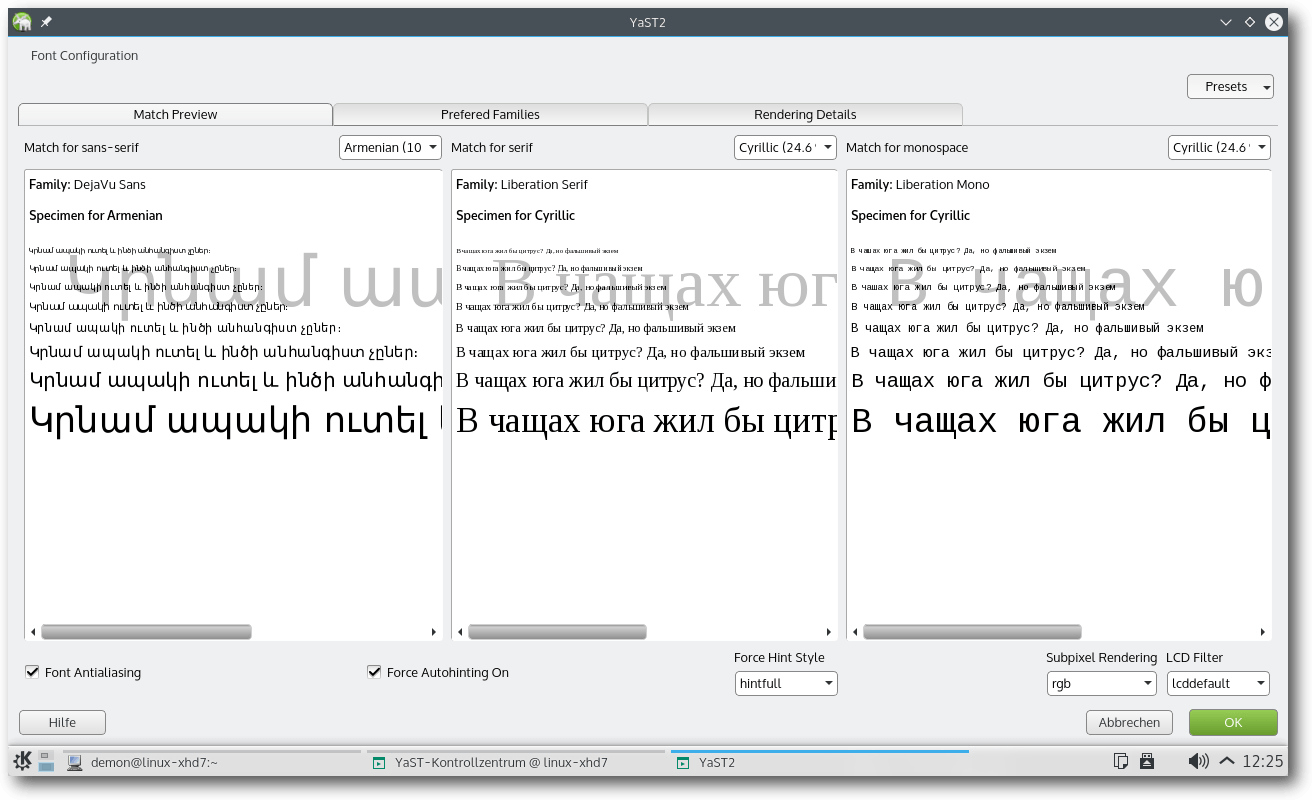

| Mirko Lindner | openSUSE 42.1 Leap |

| Daniel Myshkin | Rezension: Java Web Security |

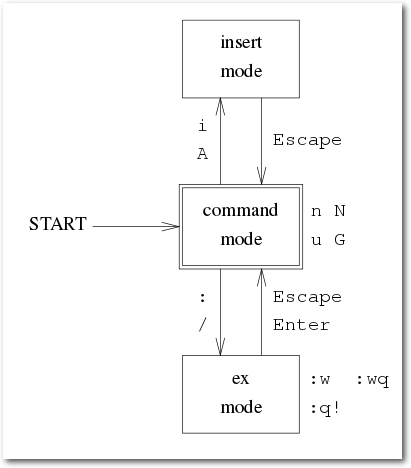

| Steffen Rumberger | Vi für typische nano-Nutzer |

| Christoph Schmidt | Let's Encrypt |

| Jochen Schnelle | Rezension: Doing Math with Python, Rezension: Coding with JavaScript for Dummies |

| Enrico Wildgrube | Rezension: Gut gerüstet gegen Überwachung im Web |

| Dr. Christoph Zimmermann | Linux Presentation Day in Frankfurt |

| Redaktion | |

| Christian Schnell | Matthias Sitte |

| Dominik Wagenführ (Verantwortlicher Redakteur) | |

| Satz und Layout | |

| Moritz Kiefer | Benedict Leskovar |

| Kai Welke | |

| Korrektur | |

| Daniel Braun | Frank Brungräber |

| Vicki Ebeling | Stefan Fangmeier |

| Mathias Menzer | Christian Schnell |

| Karsten Schuldt | |

| Veranstaltungen | |

| Ronny Fischer | |

| Logo-Design | |

| Arne Weinberg (CC-BY-SA 4.0 Unported) | |