Zur Version ohne Bilder

freiesMagazin September 2011 (ISSN 1867-7991)

Topthemen dieser Ausgabe

Plattformen für die Entwicklung und Verwaltung von Open-Source-Projekten

Beim Erlernen einer Programmiersprache macht man sich gewöhnlicherweise wenig Gedanken über eine Versionsverwaltung. Mit zunehmendem Fortschritt gelangt man jedoch häufig an einen Punkt, an dem man nicht mehr für sich alleine ein Projekt entwickelt. Besonders die Open-Source-Gemeinde ist dabei auf die Mitarbeit der Gemeinschaft aus aller Welt angewiesen. (weiterlesen)

„I don't like spam“, oder wie man einen Mailserver testet

Es begann mit einem Irrtum. Im Werbebrief vom Google für den AdWords-Dienst befand sich ein Gutschein über 75 Euro, der auf einen völlig fremden Menschen ausgestellt war. Wenn man Sandra Fründt, Head of Business Marketing Google Deutschland, auf ihren Fehler aufmerksam machen will, stößt man auf ein Problem: Im Schreiben ist überhaupt keine E-Mail-Adresse angegeben. Die Frage ist: Wie findet man die E-Mail-Adresse heraus und kann dazu noch testen, ob sie existiert? (weiterlesen)

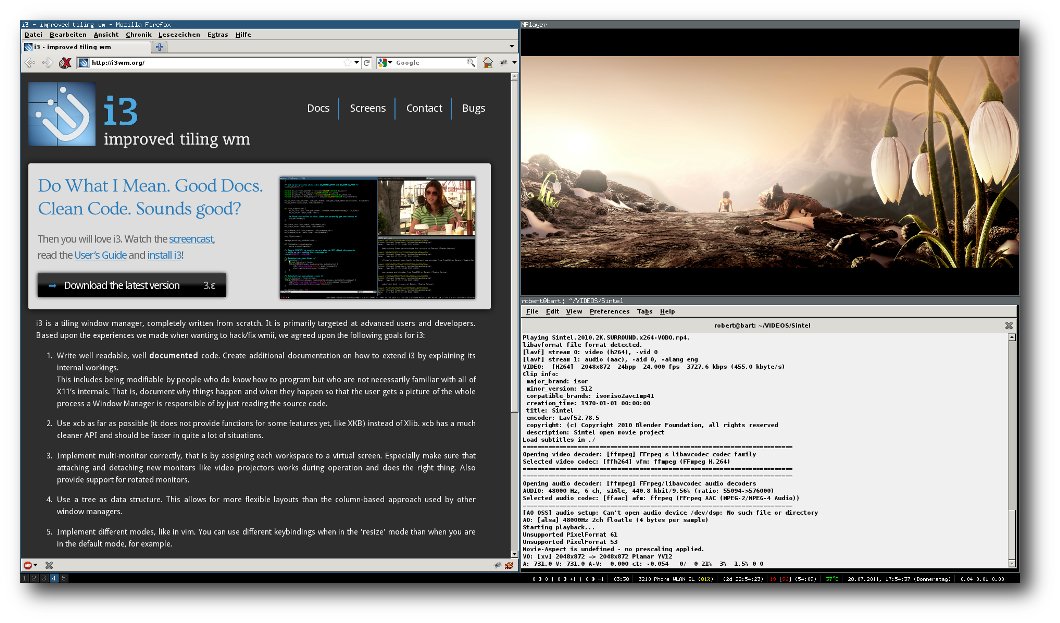

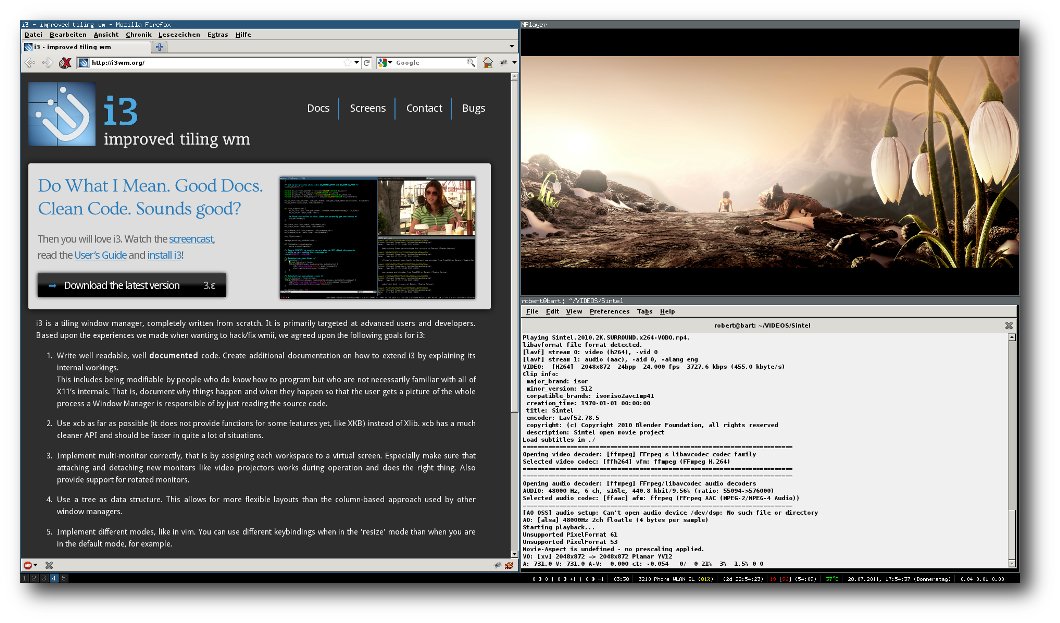

i3 – ein Tiling Fenstermanager

Fenstermanager gibt es viele, die bekanntesten sind wohl Metacity (GNOME 2), KWin (KDE) oder Compiz. Diese Fenstermanager verfolgen alle ein ähnliches Konzept: Die Fenster liegen relativ ungeordnet auf dem Bildschirm und können überall hin verschoben werden. Tiling Fenstermanager – wie i3 – bauen auf einem anderen Konzept auf: Diese behandeln den Bildschirm wie eine Art Tabelle. Dadurch sind die Fenster (bis auf Ausnahmen) an einem festen Platz und können durch Tastenkombinationen in andere Positionen gebracht werden. (weiterlesen)

Zum Index

Linux allgemein

Plattformen für die Entwicklung und Verwaltung von Open-Source-Projekten

Trinity – Desktop ohne Zukunft

Der August im Kernelrückblick

Anleitungen

Wie man einen Mailserver testet

Perl-Tutorium: Teil 2

Software

i3 – ein Tiling Fenstermanager

Cassandra – Die Datenbank hinter Facebook

Community

Rezension: The Python Standard Library

Rezension: Python von Kopf bis Fuß

Magazin

Editorial

Leserbriefe

Veranstaltungen

Konventionen

Impressum

Zum Index

Mehret und teilet Euch

freiesMagazin vergrößert sich

Letzten Monat riefen wir auf unserer Webseite [1]

und natürlich auch im Editorial der freiesMagazin-Ausgabe 08/2011 [2]

zur Unterstützung unseres Teams auf. Gesucht waren Layouter, Korrektoren

und Autoren.

In den ersten beiden Kategorien hatten wir viele Zuschriften, sodass

wir das Team entsprechend aufstocken konnten. Acht neue Mitglieder

hat freiesMagazin dazu gewonnen, die uns nun tatkräftig unterstützen und

die alten Teammitglieder entsprechend entlasten. Die Alteingesessenen

werden den „Noobs“ aber natürlich ebenfalls mit Rat und Tat zur

Seite stehen.

Autoren werden aber natürlich auch weiterhin gesucht. Derzeit

erkennen wir bei geplanten Artikeln einen sehr starken Hang zu

Programmierthemen. Sicherlich ist ein Großteil unserer Leser

irgendwie mit Programmiersprachen in Kontakt, sodass sich die

meisten dafür begeistern können. Dennoch wollen wir auch etwas

Abwechslung bieten, sodass jeder dazu aufgerufen ist, das Magazin

mitzugestalten. freiesMagazin lebt von den Inhalten, die von den Lesern

für die Leser geschrieben werden.

freiesMagazin teilt sich

Ein Leser fragte uns kürzlich, ob man die Artikel im Magazin auch

einzeln als PDF herunterladen kann. Bisher ist so etwas nicht möglich,

auch wenn sich natürlich jeder mit pdftk (siehe freiesMagazin 03/2009 [3])

oder per Druckdialog seine Lieblingsthemen selbst speichern kann.

Dennoch möchten wir wissen, ob der Wunsch bei den Lesern überhaupt

da ist, das PDF in einzelnen Teilen direkt herunterladen zu können.

Aus dem Grund haben wir eine Umfrage gestartet [4].

Dabei kam dann auch gleich die Frage auf, ob man die HTML-Mobilversion

ebenfalls nicht besser in einzelne Seiten aufspaltet und nicht mehr

als ganzes anbietet. Dies würde dann eine direkte Verlinkung leichter

machen und spart auch etwas Ladezeit. Zusätzlich kann man diese

Versionen dann leichter drucken, wenn man nur an einem Thema

interessiert ist.

Wir sind gespannt auf Ihre Antworten

und wünschen Ihnen nun viel Spaß mit der Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/20110725-freiesmagazin-sucht-unterstuetzung

[2] http://www.freiesmagazin.de/freiesMagazin-2011-08

[3] http://www.freiesmagazin.de/freiesMagazin-2009-03

[4] http://www.freiesmagazin.de/20110828-sollen-artikel-einzeln-abrufbar-sein

Das Editorial kommentieren

Zum Index

von Patrick Meyhöfer

Beim Erlernen einer Programmiersprache macht man sich gewöhnlicherweise

wenig Gedanken über eine Versionsverwaltung. Mit zunehmendem Fortschritt

gelangt man jedoch häufig an einen Punkt, an dem man nicht mehr für sich

alleine ein Projekt entwickelt. Besonders die Open-Source-Gemeinde ist dabei

auf die Mitarbeit der Gemeinschaft aus aller Welt angewiesen.

In der Regel kann ein Versionsverwaltungssystem wie CVS, SVN, Git oder Mercurial,

um nur

einige zu nennen, auch einfach über die Paketverwaltung

auf dem eigenen System installiert und genutzt werden. Der Reiz der

nachfolgenden Plattformen ist jedoch, dass diese weltweit über das Internet

von jedem Entwickler und potentiell interessiertem Nutzer erreichbar sind

und einige interessante Zusatzfunktionen bieten.

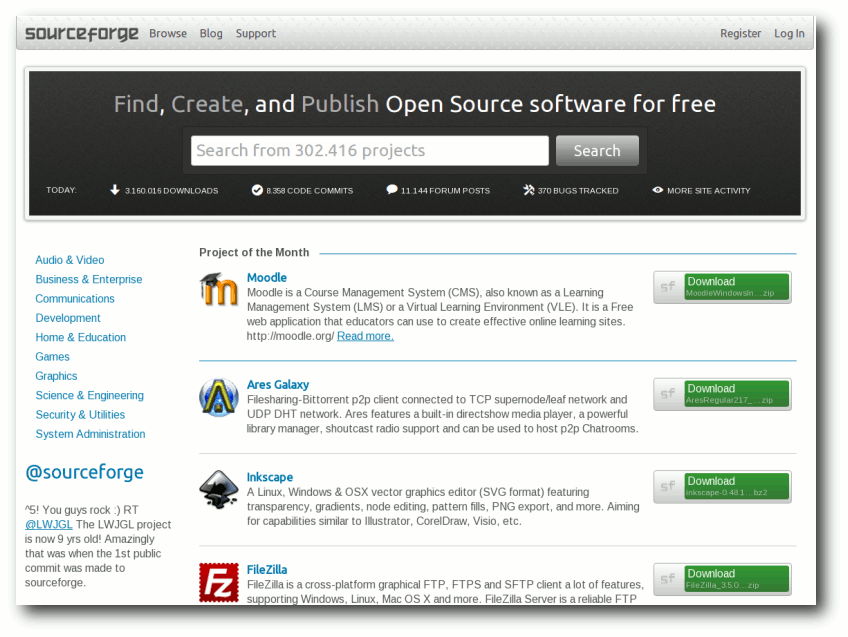

SourceForge

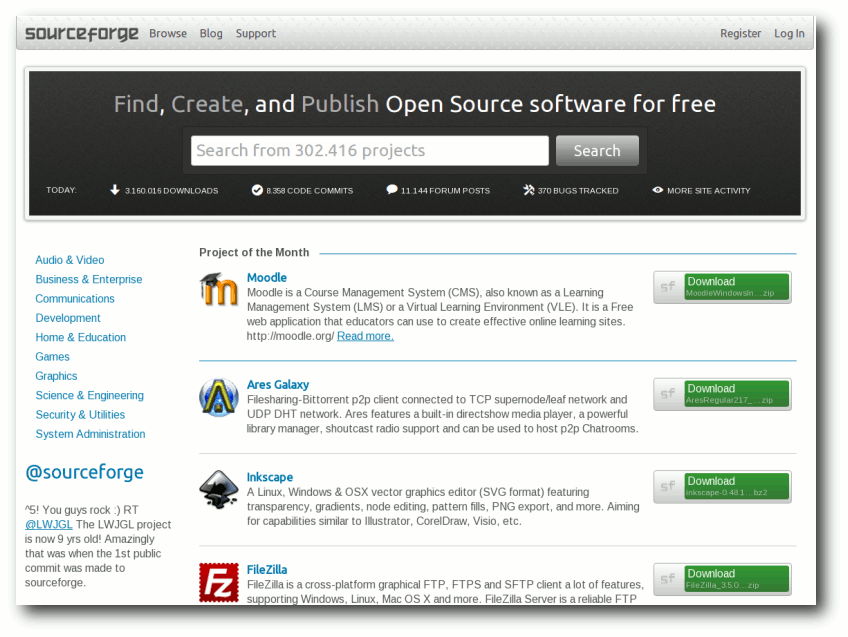

Eine der ältesten (1999 gegründet) und am meisten genutzten Plattformen mit

über 300.000

Projekten und mehr als 2 Millionen registrierten Benutzern

ist SourceForge [1].

Viele bekannte Programme hosten ihren Quelltext

dort, z. B. Inkscape, FileZilla, Pidgin u. v. m.

Die Startseite von SourceForge.

Funktionen

Schaut man sich die umfangreichen

Funktionen [2]

von SourceForge näher an, bemerkt man, dass bereits fast alles vorhanden ist,

was man sich als Entwickler so vorstellen kann:

- unterstützt werden Git, Mercurial und SVN

- zentrales Verzeichnis (engl. Repository) des gesamten Quelltextes und

weiterer Dokumente, sowie Mailinglisten, Foren und Diskussionsbeiträge

- Berechtigungsvergabe

- detaillierte Statistiken

- Ticketsystem für Fehlermeldungen

Registrierung und Erstellung eines Projektes

Die Registrierung läuft problemlos und schnell ab. Da es heute bereits fast

zum guten Ton gehört, bietet auch SourceForge eine Registrierung über OAuth

an, sodass man nicht das Registrierungsformular ausfüllen muss, sondern sich

über Anbieter wie Google oder Yahoo, nach einer kurzen Bestätigung auf

SourceForge anmelden kann.

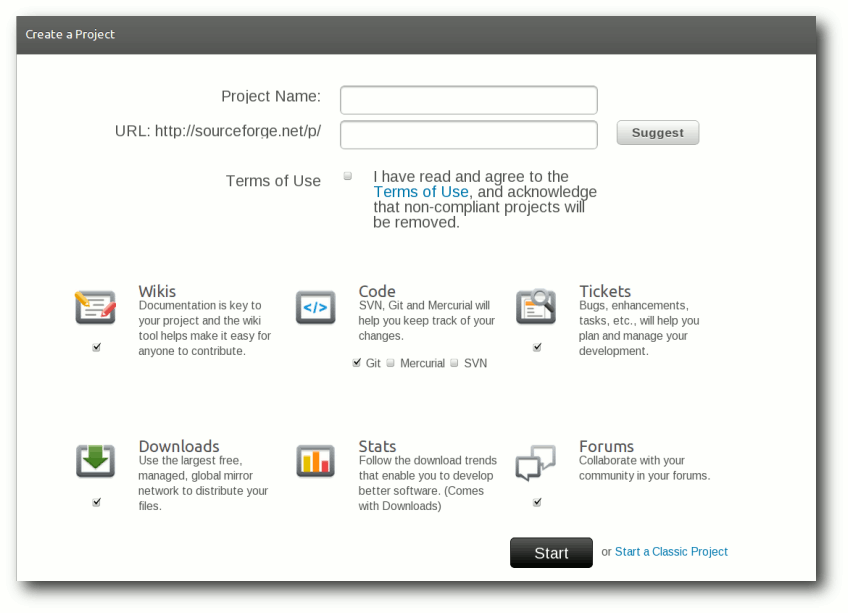

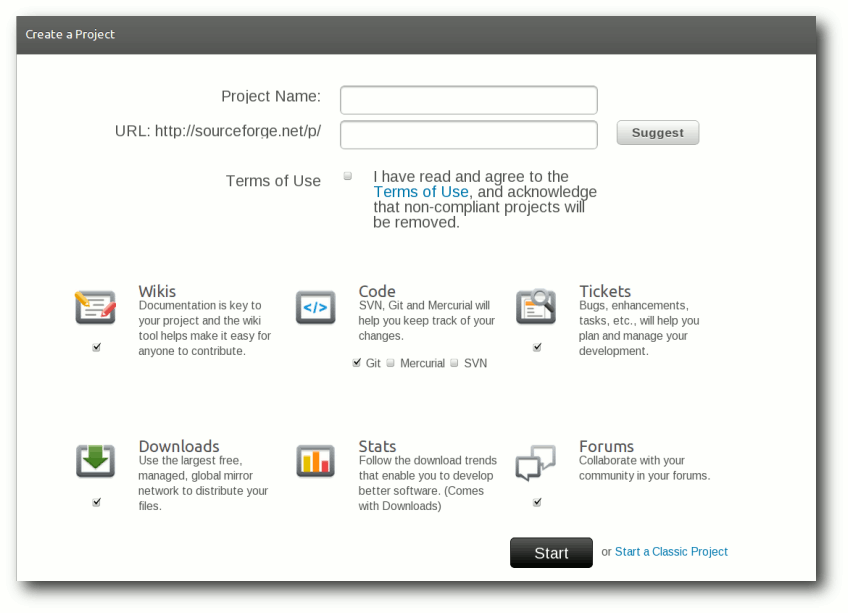

Ein Projekt ist nach der Anmeldung sehr schnell erstellt. Man vergibt einen

Projektnamen und eine URL, unter der das Projekt erreichbar ist.

Ein Projekt auf SourceForge erstellen.

Zusätzlich kann man verschiedene Optionen auswählen, wobei die Verwendung

des Versionssystems eine der wichtigsten Entscheidungen ist. Sind alle

Einstellungen erledigt, landet man in dem optisch gut gestalteten

Admin-Bereich.

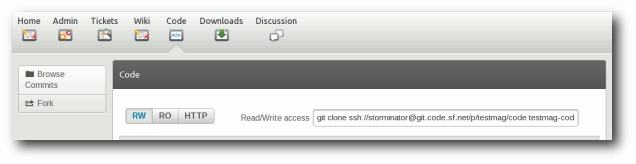

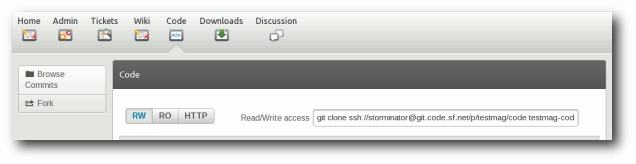

Die Administrationsmöglichkeiten bei SourceForge.

Ab da kann man mit der Verwaltung des Projektes beginnen, u. a. mit dem

Einblick in offene Tickets, dem Schreiben von Wikiseiten, dem Einsehen von

Statistiken usw.

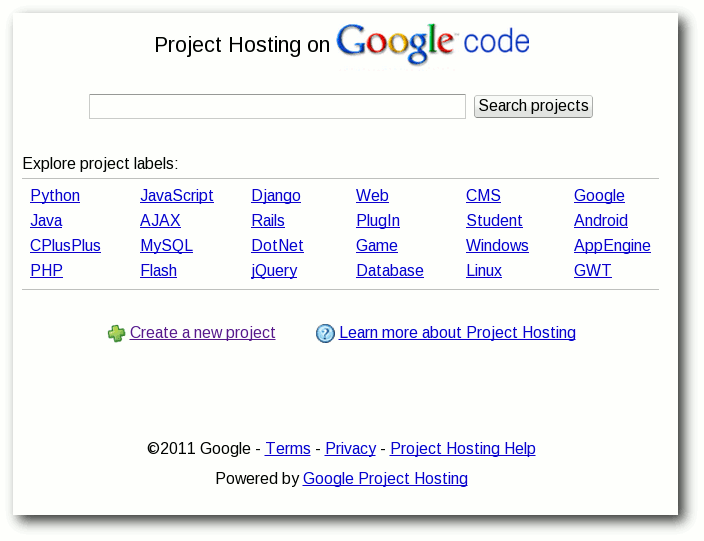

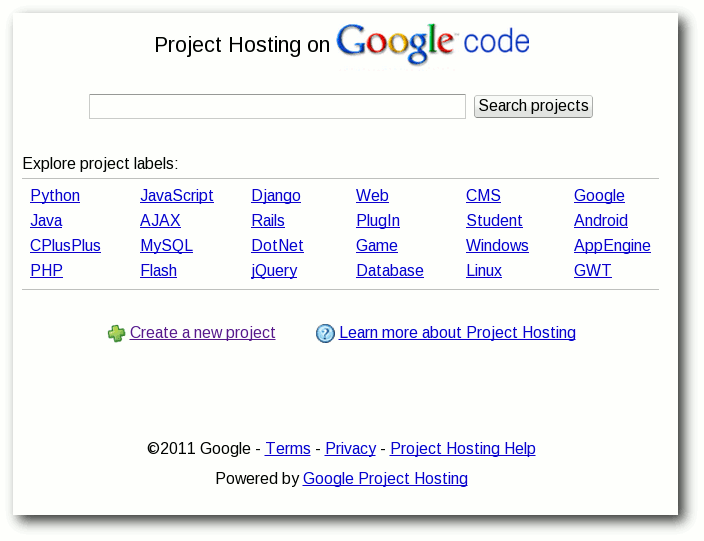

Google code

Ebenfalls sehr beliebt ist die Plattform Google code [3].

Google nutzt die Plattform als seine zentrale Basis für die Entwicklung des

Smartphone-Betriebssystems Android oder für das Google Web Toolkit. Zudem bietet

es aber allen Entwicklern von Open-Source-Projekten ebenfalls eine Möglichkeit,

ihr Projekt zu veröffentlichen und zu verwalten.

Die Startseite von Google code.

Funktionen

Etwas weniger umfangreich als SourceForge, aber doch mit allen nötigen

Funktionen, die man zum Grundumfang zählen sollte, kann auch Google code

aufwarten.

So stellt Google folgende Funktionen bereit:

- zentrales Verzeichnis (engl. Repository) des gesamten Quelltextes und

weiterer Dokumente

- 2 GB Speicherplatz für Dateien im Verzeichnisbaum und

2GB im Downloadbereich

- unterstützt werden Git, Mercurial und SVN

- Dateien online bearbeiten inklusive

Syntax-Hervorhebung (wurde extra für Chrome OS eingeführt)

- Wiki

- Ticketsystem für Fehlermeldungen

Vor kurzem erst ist das Versionskontrollsystem Git hinzugekommen, Google

bietet jedoch auch eine Portierung von SVN nach Git

an [4].

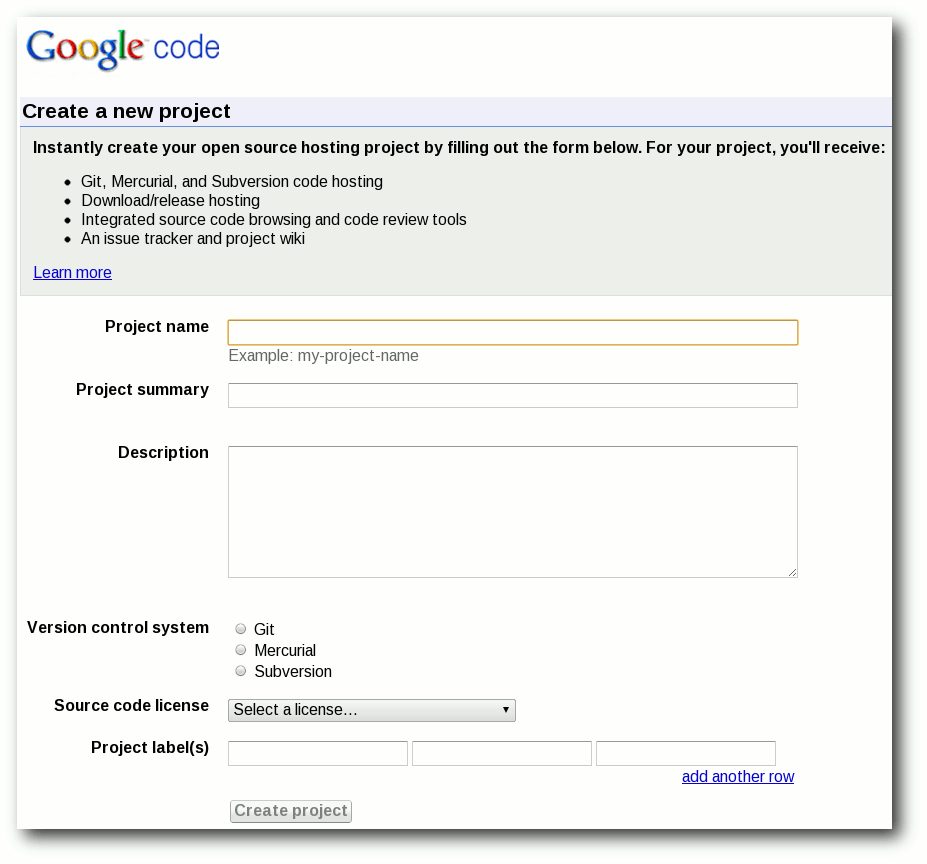

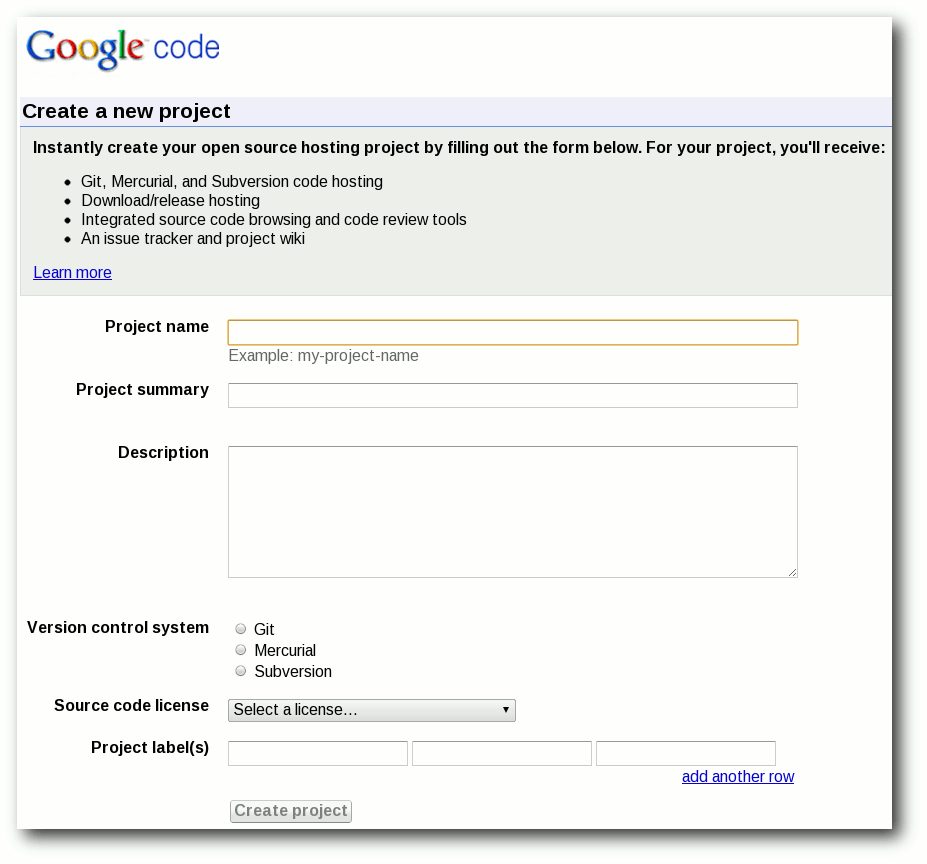

Registrierung und Erstellung eines Projektes

Sofern man einen Google-Account sein Eigen nennt, benötigt man keine weitere

Registrierung und kann direkt auf der Einstiegsseite ein neues Projekt

erstellen.

Es werden, ähnlich wie bei SourceForge, lediglich einige wenige

Standardinformationen abgefragt. Man sollte allerdings, wie bei fast allen

Plattformen, der englischen Sprache zumindest grundlegend mächtig

sein, da die Seiten selten ins Deutsche übersetzt sind.

Ein Projekt auf Google code erstellen.

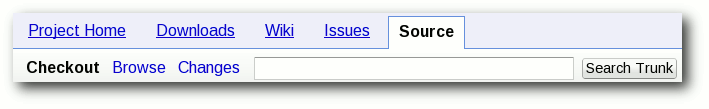

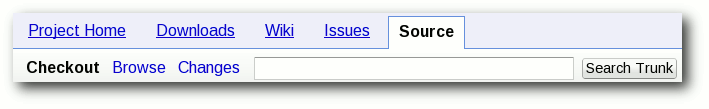

Anschließend landet man im Admin-Bereich, der Google-typisch recht schlicht

und im klassischen Design gehalten ist.

Der Administrationsbereich von Google code.

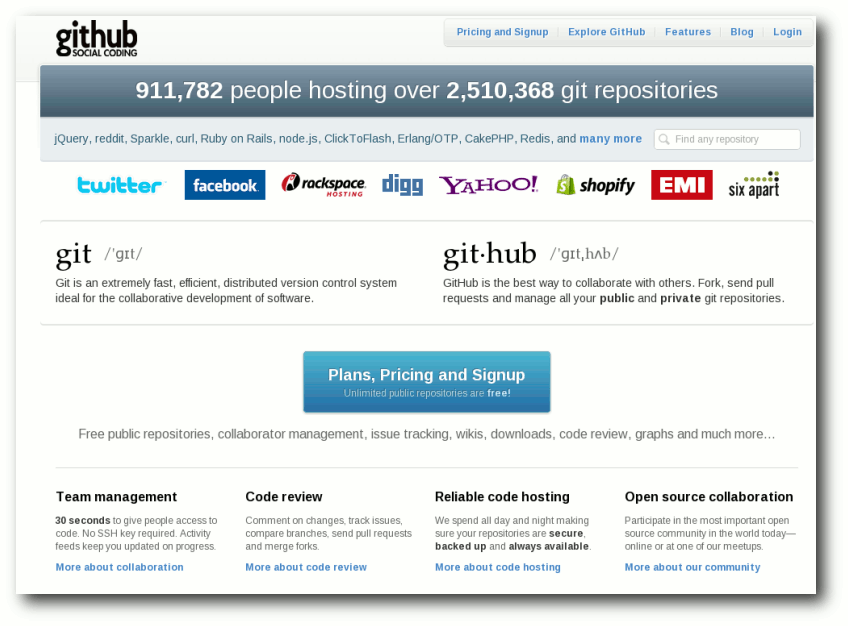

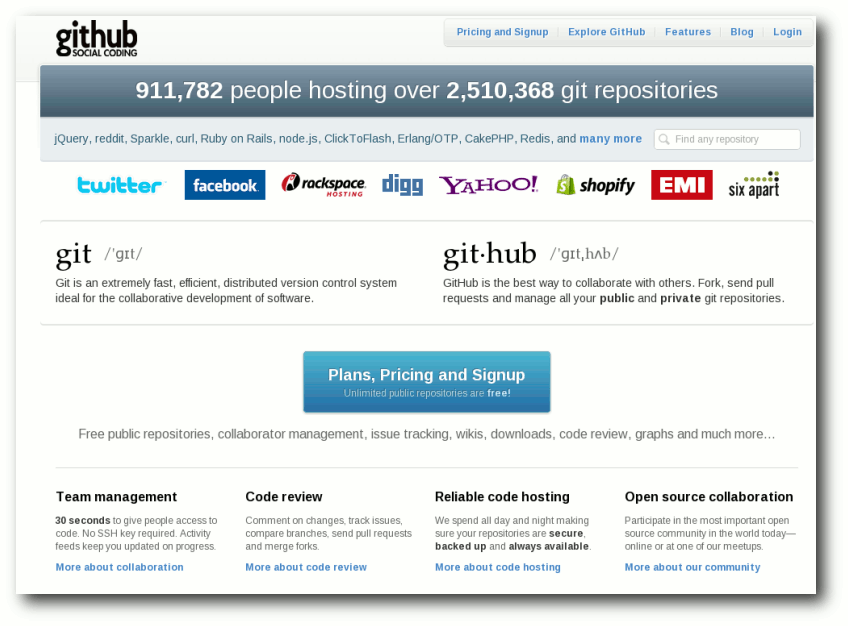

GitHub

Mit der wachsenden Beliebtheit von Git als verteiltes, dezentrales System

(d. h. man benötigt nicht zwingend einen Server) findet GitHub [5]

immer größeren Zuspruch [6].

Laut eigener Aussage nutzen bereits über 900.000 angemeldete Benutzer GitHub.

Im Gegensatz zu SourceForge oder Google code bietet GitHub auch Hosting

gegen Bezahlung an, sofern das entwickelte Projekt keine Open-Source-Lizenz

besitzt. Für alle quelloffenen Projekte ist die Plattform jedoch kostenlos.

Einige sehr bekannte Projekte, die ihre Quelltexte auf GitHub verwalten sind

z. B. jQuery, PHP und Perl.

Die Startseite von GitHub.

Funktionen

Im Vergleich zu den bereits vorgestellten Plattformen steht auch GitHub in

Sachen Funktionalität nicht nach. So bietet GitHub:

- zentrales Verzeichnis (Repository) des gesamten Quelltextes und

weiterer Dokumente

- Quelltext-Management nur mit Git

- Dateien online bearbeiten, inklusive Syntax-Hervorhebung

- Wiki

- Ticketsystem für Fehlermeldungen

GitHub ist bestrebt, eine Plattform anzubieten, auf der die Nutzer

untereinander interagieren, ein sogenanntes „social coding“.

Dies bedeutet,

dass Kommentare bei den Quelltexten möglich sind und dass man

unterschiedlichen Entwicklern bei ihren Projekten verfolgen kann. Es ist

ausdrücklich gewünscht auch mit dem Entwickler

in den Kontakt zu treten, um

einen Meinungsaustausch zu ermöglichen.

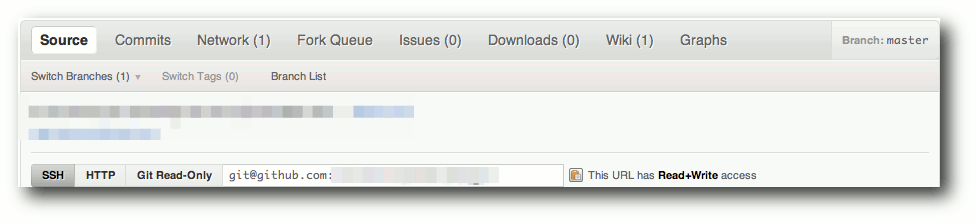

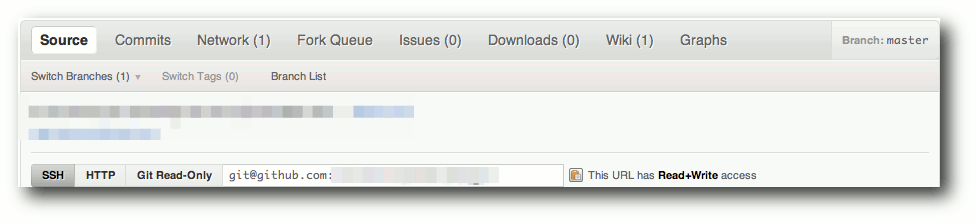

Registrierung und Erstellung eines Projektes

Bei der Registrierung muss man sich entscheiden, ob man einen kostenlosen

Account anlegt, der dann nur für Open-Source-Projekte

genutzt werden darf oder verschiedene

andere Preismodelle nutzt. Es werden bei der

Anmeldung nur Benutzername, E-Mail-Adresse und das Passwort für die Registrierung benötigt.

Die Prozedur im Anschluss ist analog zu oben bereits beschriebenem Vorgehen:

Projekt nach dem Login erstellen und man gelangt zum Adminbereich.

Die Verwaltung des Projekts auf GitHub.

Alternativen in der Kurzübersicht

Die drei aufgeführten Plattformen sind meiner Meinung nach die

populärsten und meist genutzten Angebote in der FOSS-Gemeinschaft.

Wer bisher noch keine passende Plattform in diesem Beitrag gefunden hat,

sollte sich einmal folgende Alternativen näher ansehen:

- Gitorious [7] – als Alternative zu GitHub

- Launchpad [8] – besonders bei der Ubuntu-Entwicklung

interessant und viel genutzt (PPA erstellen etc.); nutzt Bazaar

- Codeplex [9] – von Microsoft, vorwiegend für

die .NET-Entwicklung genutzt

- Bitbucket [10] – für Mercurial-Projekte

- BerliOS [11] vom Fraunhofer-Institut betrieben und

durch öffentliche Gelder gefördert

- JavaForge [12] – läuft auf der Amazon Cloud

Fazit

Wer einen guten und verlässlichen Dienst für seine Entwicklung sucht, ist

mit allen Diensten gut bedient. Für kleinere und mittlere Projekte bietet

sich meiner Meinung nach Google code an, da es eine sehr übersichtliche

und schnelle Benutzerschnittstelle bietet. Der Registrierungsprozess, wenn

man noch kein Google-Konto besitzt, ist allerdings der aufwändigste.

Legt man mehr Wert auf große Funktionsvielfalt und der jahrelangen

Erfahrung, ist man mit großen Projekten bei SourceForge besser aufgehoben.

Der neue Trend für alle, die auf Git setzen, scheint derzeit GitHub zu sein.

Das relativ junge Projekt mit dem neuartigen Ansatz scheint für die Zukunft

ebenfalls gerüstet.

Möchte man keinem fremden Dienst seine Quelltexte anvertrauen, so ist als

Alternative auch ein eigens aufgesetzter Server möglich, der verhältnismäßig

schnell eingerichtet ist.

Links

[1] http://sourceforge.net/

[2] http://sourceforge.net/apps/trac/sourceforge/wiki/WikiStart#HostingwithSourceForge.net

[3] http://code.google.com/hosting/

[4] http://www.linux-magazin.de/NEWS/Google-gibt-Git-Support-fuer-Google-Code-bekannt

[5] https://github.com/

[6] http://www.heise.de/developer/meldung/Microsoft-Open-Source-Entwickler-bevorzugen-Code

[7] http://gitorious.org/

[8] https://launchpad.net/

[9] http://www.codeplex.com/

[10] https://bitbucket.org/

[11] http://www.berlios.de/

[12] http://www.javaforge.com/project/11

[13] http://redmonk.com/sogrady/2011/06/02/blackduck-webinar/

[14] http://en.wikipedia.org/wiki/Comparison_of_open_source_software_hosting_facilitie

[15] http://www.netzwelt.de/news/87291_2-einfuehrung-dezentrale-versionsverwaltung-programm-git.html

| Autoreninformation |

| Patrick Meyhöfer (Webseite)

ist durch sein Studium auf die verschiedenen

Versionskontrollsysteme aufmerksam geworden und hat seitdem viele

Hostingangebote für Open-Source-Software getestet.

|

| |

Diesen Artikel kommentieren

Zum Index

von Martin Gäßlin

Das Trinity Desktop Environment [1] ist ein

von Timothy Pearson ins Leben gerufener

Fork [2]

der Desktopumgebung KDE 3.5. In diesem Artikel wird aus Sicht eines

KDE4-Entwicklers dargestellt, wieso das Projekt keine Zukunft hat.

Was ist Trinity?

Trinity startete anfangs mit einigen Codeänderungen an KDE 3.5,

die für ein weiteres KDE 3.5.11 vorgeschlagen wurden, nachdem die

ersten Releases der moderneren 4.x-Serie bereits erfolgt

waren [3].

Dies wurde von vielen KDE-Entwicklern mit Unverständnis

aufgenommen [4]

und vom Release Team wurde klargestellt, dass es keine weiteren

Releases für KDE 3.5 geben wird und der Branch für Feature-Entwicklung

geschlossen ist [5].

Des Weiteren wurde es als Problem angesehen, dass der Code nicht von

den Hauptentwicklern begutachtet wurde und deshalb, um

Verwechslungen zu vermeiden, nicht den Namen „KDE“ verwenden

sollte [6].

Dies führte im März 2010 dann zur ersten Veröffentlichung von

Trinity mit der Versionsnummer 3.5.11 [7].

Trinity startete mit dem Code von KDE 3.5.10 und integrierte eigene

Patches und Patches von verschiedenen Distributionen, die zu diesem

Zeitpunkt KDE 3.5 noch im Angebot hatten. Trinity lebt als eigener

Branch in den KDE-Repositories [8].

Man könnte also sagen, dass Trinity den „Segen“ von KDE erhalten hat,

3.5 zu forken.

Geschichtlicher Abriss

KDE 3.5 erblickte im November 2005, vor mehr als fünf Jahren, das

Licht der Welt. Seitdem wurden nur noch Maintenance-Releases

veröffentlicht, welche mit 3.5.10 im August 2008, also etwa drei

Jahre nach dem ersten Release, eingestellt wurden. Das 3.5-Release

wurde von der Community als letzte Veröffentlichung der 3.x-Serie

geplant und in dem Release Announcement findet sich bereits der

Hinweis, dass die nächste Version KDE 4 sein

wird [9]. Über die

APPEAL-Meetings [10]

wurde die Richtung ausgearbeitet, in welche die zukünftige Entwicklung

weitergehen sollte. Dies zeigte sich auch auf der

Entwicklerkonferenz aKademy 2005 in Malaga, bei der KDE4 das große

Thema war [11].

Nun entscheidet sich eine Entwickler-Community wie KDE mit hunderten

von Entwicklern nicht einfach so aus Spaß für ein Projekt wie KDE4

und die großen Änderungen, die damit einhergingen. Hierfür muss es

triftige Gründe geben. Einer davon war, dass im Juni 2005

die erste Version von Qt 4 veröffentlicht wurde und KDE 3.5 noch

auf Qt 3 aufbaute. Qt 4 stellte einen größeren Umbruch dar, bei dem

es mit einfachem Neu-Kompilieren nicht getan ist. Vieles muss

konzeptionell anders angegangen werden, was im Endeffekt zu einem

Neuschreiben großer Teile der GUI Schicht führt.

In vielen Bereichen erkannten die Maintainer, also die Entwickler,

die den Code am besten kennen, dass die Quellcodebasis sich nicht

dafür eignet eine Plattform zu schaffen, um die Entwicklung über das

nächste Jahrzehnt zu tragen. Dies führte zur Einstellung einiger

Komponenten und zum Neuschreiben von Anwendungen und Frameworks.

Das populärste Beispiel dafür dürfte das von Aaron Seigo, damals

Maintainer der KDE-Kontrollleiste Kicker, initiierte Projekt des

Plasma Desktops [12]

sein, der sowohl Kicker, KDesktop als auch Superkaramba ersetzen

sollte. Kicker zeigte nicht die Flexibilität, die erwünscht war. So

war Kicker eine Kontrolleiste und egal, wie viele Schalter man

bewegte, es blieb eine Kontrollleiste. Plasma hingegen ist

heutzutage ein flexibles Framework zum Erstellen individueller

Workspaces, wie im Artikel „Plasma erobert die Welt“ in freiesMagazin

01/2011 [13]

dargestellt wurde. Ein Ziel war es, bei der Entwicklung nie wieder in eine

Situation zu kommen, den Desktop komplett wegschmeißen und

reimplementieren zu müssen. Betrachtet man aktuell die Aktivitäten

bezüglich Applets in QML und der Umstellung auf

libplasma2 [14],

so ist offensichtlich, dass dieses Ziel erreicht wurde.

Wem ist geholfen mit Trinity?

Mittlerweile liegt KDE Plasma mit dem Ende Juli veröffentlichten KDE

Plasma Workspaces 4.7 in der achten Inkarnation vor. Die

Funktionalität der alten Anwendungen Kicker, KDesktop und

Superkaramba ist bis auf wenige kleine Ausnahmen vollkommen

implementiert. Zusätzlich gibt es hunderte von Funktionen, die

mit dem alten Framework nicht möglich gewesen wären. Über die

Themeingfunktionalität und die vielseitigen

Einstellungsmöglichkeiten lässt sich auch sehr leicht ein Desktop

nachbauen, der aussieht und sich verhält wie KDE 3.5.

Natürlich steht es jedem Anwender frei, zu nutzen, was er will und

jedem Entwickler, zu arbeiten, woran er will. Das ist ja gerade der

Vorteil Freier Software. Gäbe es genügend Entwickler, die mit

den Entwicklungen von KDE 4 nicht einverstanden gewesen wären, so

hätte KDE 3.5 weiterentwickelt werden können. Dies war aber nicht

der Fall und somit stellt sich die Frage, wem mit Trinity geholfen

ist, wenn mit wenigen Einstellungsveränderungen auch das „KDE3.5

computing style“ erhalten werden kann, wie es das Ziel von Trinity

ist [15]. Geht es nur darum,

Kicker, KDesktop und Superkaramba unabhängig von KDE Plasma als

Desktopumgebung zu erhalten, stellt sich die Frage, warum dann das

komplette KDE 3.5 geforkt wurde. Nicht alle Bereiche des Desktops

wurden neu geschrieben, viele Anwendungen auch inkrementell

weiterentwickelt ohne Verlust von bestehender Funktionalität, wie

beispielsweise der Fenstermanager KWin.

Die Funktionalität von Trinity ist durch den in KDE 3.5 vorgegebenen

Feature Freeze auf dem Stand von 2005 eingefroren. Das betrifft

alle Komponenten. So muss man sich doch fragen, was man zum

Beispiel mit einem Webbrowser (Konqueror) und Rendering-Engine

(KHTML/KJS) will, der die letzte Funktionalität weit vor dem Start

von HTML 5 oder der heutzutage weit verbreitesten JavaScript-Bibliothek

jQuery [16] erhalten

hat? Bei solchen Komponenten wäre es doch eigentlich sinnvoller, die

neuere Komponenten zu verwenden, allein schon, um die Bugfixes

zu erhalten.

Selbstverständlich hatte KDE 3.5 auch Bugs, sonst hätte es ja keinen

Bedarf für 10 Minor Releases gegeben. Auch mit KDE 3.5.10

wurden nicht alle offenen Fehler beseitigt und in den weiterhin

bestehenden Komponenten wurden in den 4.x-Releases viele Fehler

behoben, die auch schon in KDE 3.5 präsent waren. Da 3.5 aber von

den Entwicklern verlassen wurde, werden solche Bugfixes nicht

zurückportiert. In vielen Fällen sind die aktuellen Entwickler erst

nach KDE 3.5 hinzugestoßen und haben selbst nie an KDE 3.5

entwickelt. Durch Umstellung des Build-Systems von

autotools [17] auf

CMake [18] ist es auch nicht

leicht, mal eben schnell einen Patch unter KDE 3.5 zu testen. Hinzu

kommt, dass die Entwickler nicht wissen, ob Fehler in 3.5 auch

bestanden, und es werden kaum noch Fehler für 3.5 gemeldet.

Für die Trinity-Entwickler ist es somit nicht einfach,

Änderungen bei weiterbestehenden Komponenten aus der 4.x-Serie

nach Trinity zurückzuportieren. Die Nutzer von Trinity müssen

weiterhin mit den alten und zum Teil seit Jahren behobenen Fehlern

leben.

Problem der Abhängigkeiten

Die grundsätzlichen Probleme, die zur Entwicklung der 4.x-Serie

führte, bestehen natürlich auch für Trinity. Qt 3 hat sein

End-of-life vor Jahren erreicht [19],

und um zukunftssicher zu bleiben, muss Trinity auf Qt 4 umstellen.

Die Debian-Qt/KDE-Maintainer planen Qt 3 in Wheezy nicht mehr

bereitzustellen [20].

Der grundsätzliche Aufwand zur Portierung auf Qt 4 ist natürlich

für Trinity genauso vorhanden, wie er für die KDE-Community

bestand. Zwar bietet Qt 4 eine Kompatibilitätsschicht an, jedoch

wird diese mit Qt 5 entfernt, das sich bereits in Entwicklung

befindet. Um zukunftssicher zu bleiben, muss Trinity einen

kompletten Port durchführen, der in vielen Teilen zu einem Rewrite

führen wird, wie er auch für KDE 4.x nötig war. In all den

Bereichen, in denen die Anwendungen weiterleben, stellt sich die

Frage, warum man erneut durchführt, was bereits durchgeführt wurde?

Warum zweimal auf Qt 4 portieren mit all den Problemen, die das mit

sich bringt?

Aber natürlich ist nicht nur Qt ein Abhängigkeitsproblem. Der

komplette Linux-Stack befindet sich in ständiger Bewegung und eine

einzige Komponente einzufrieren, ist kaum möglich. So verwendet

Trinity noch HAL [21],

obwohl fast alle Distributionen HAL entfernen, da es von niemandem

mehr verwendet wird und die Funktionalität in den Linux-Kernel

verlagert wurde. So besteht ständig die Gefahr, dass der Stack sich

in eine Richtung bewegt, die es unmöglich macht, Trinity ohne

Anpassungen zu verwenden. So findet man auch in der

Trinity-Roadmap [22]

hauptsächlich Aufgaben in diesem Bereich. Aufgaben, um das tote KDE

3.5 irgendwie mit einem neueren Stack am Leben zu erhalten. Neue

Funktionen kommen dadurch noch nicht hinzu und das

Regressionspotential ist selbstverständlich sehr hoch.

Manpower

Die KDE Community besteht heutzutage aus hunderten von Entwicklern,

die spezialisiert an einem Bereich arbeiten. Es gibt kaum

Entwickler, die über alle Bereiche hinweg wirken. Dies ist auch

logisch: Man spezialisiert sich und kann nicht qualifiziert in

anderen Bereichen entwickeln. Ein Workspace-Entwickler wird somit

nicht in der Lage sein, konstruktiv zu KDEPIM beizutragen. Für

Trinity gilt natürlich das Gleiche. Die Entwicklergemeinschaft an

Trinity müsste ähnlich groß sein wie die von KDE. Jedoch kann man,

wenn man sich den SVN Log anschaut, die aktiven Trinity-Entwickler

an einer Hand abzählen. Dies ist natürlich keine Ausgangsbasis, um

eine Desktopumgebung zu entwickeln. Natürlich besteht immer die

Hoffnung, neue Entwickler anzuwerben. Das dürfte aber bei einer

Codebasis, die von den ursprünglichen Entwicklern aufgegeben wurde,

schwierig sein. Auch müssten unabhängige Entwickler sehr schnell

wieder zum gleichen Schluss kommen, wie die KDE-Entwickler: Die

Basis eignet sich nicht, um sie weiterzuentwickeln, ein Rewrite ist

erforderlich.

KDE trennt die Aufgaben der Software-Entwicklung und Paketierung.

Die KDE-Community stellt nur Quellcode zur Verfügung und die

Distributionen erstellen daraus Pakete. In Trinity ist dies nicht

der Fall, die Entwickler müssen auch eigene

Paketquellen [23] pflegen.

Der Aufwand wird dabei ständig wachsen, beispielsweise durch das

Entfernen Qt 3 aus den offiziellen Paketquellen.

Aber nicht nur Entwickler und Paketbauer werden benötigt, auch

Übersetzer. Bereits seit Mai 2009 wurden die Übersetzungen für KDE 3.5

eingestellt [24].

Das automatisierte Übersetzungssystem in der KDE-Infrastruktur

berücksichtigt nur noch aktuelle Releases, womit Trinity ein

eigenes Übersetzungssystem einführen müsste und eigene Übersetzer

finden muss. Das ist kein leichtes Unterfangen, wenn man sieht, dass

selbst stark genutzte Software, wie die der KDE-Community,

Probleme hat, Übersetzer für alle Sprachen zu finden.

Qualität

Als letzter Punkt soll die Qualität betrachtet werden. Die KDE-Community

legt hohen Wert auf Codequalität. Dazu gibt es statische Code

Checker [25], welche einfach zu behebende Fehler aufdecken.

Diese Checks schließen den Trinity-Branch nicht mit ein und sind zudem an Qt 4

angepasst. Codeänderungen in KDE werden immer im

Peer-Review-Verfahren [26]

begutachtet. Für größere Änderungen gibt es eine

ReviewBoard-Instanz [27] und diese vorgeschlagenen

Änderungen werden mit der Community über die Mailinglisten diskutiert.

Für triviale Änderungen, die nicht über ReviewBoard laufen, erfolgt

zumindest ein Post-Commit-Review durch die Maintainer. Continuous

Integration und eine große Anzahl von Entwicklern und Testern, die

tagtäglich den neuesten Stand von KDE-Software in ihrem produktiven

Arbeitsumfeld einsetzen, stellen sicher, dass die Software nicht von

Regressionen heimgesucht wird.

Bei Trinity gibt es jedoch keinen Code-Review. Wer sollte es auch reviewen?

Die Software ist ohne Maintainer und es gibt niemanden mehr, der sich

verlässlich mit dem Code auskennt. Änderungen in dem Umfang einer Portierung von Qt 3 nach Qt 4 sind daher sehr gefährlich. Es gibt nicht

nur keine Reviews, sondern auch keine gute Commit Policy. In Trinity

wurde eine Vielzahl an Bulk-Änderungen vorgenommen. So zum Beispiel eine

Menge an Änderungen [28]

als Bugfixes vom Chakra-Projekt. Ob dies wirklich Bugfixes waren oder nicht,

ist schwer zu beurteilen. Die Änderungen betreffen zum Beispiel den

Fenstermanager KWin, aber die Entwickler wurden nie um ein Review gebeten.

Dies schließt Dateien ein, die essentielles Verhalten wie die Stackingorder

betreffen. Fehler in diesem Bereich sind schwer zu bemerken und noch

schwieriger zu finden. Die Entwicklung dieser Komponente ist abgeschlossen

und die Anzahl an Änderungen vom KWin-Team ist sehr gering. Kann man davon

ausgehen, dass die Trinity-Entwickler diese zentrale, schwer zu verstehende

Komponente so gut beherrschen, dass sie ohne Hilfe Änderungen vornehmen können?

Richtig gefährlich wird es aber, wenn die Trinity-Entwickler

Änderungen an Komponenten mit ABI-Versprechen vornehmen. In einem

der „Bugfixes“ von Chakra findet sich eine Änderung an einer Header

Datei für die Fensterdekorationen [29].

Diese Änderung bricht die binäre Schnittstelle der Fensterdekorations-API. Eine für KDE 3.2+ kompilierte Fensterdekoration wird mit

Trinity nicht mehr funktionieren. In diesem Fall würde dies nur zu

einem Laufzeitfehler führen, bei Änderungen zur Umstellung auf Qt 4

jedoch zu einer kompletten inkompatiblen ABI und API [30].

Das Ergebnis ist, dass der Fenstermanager beim Starten direkt

abstürzt, wenn eine 3rd-Party-Dekoration verwendet wird. Die

KDE-Entwickler hatten bei ihrer Portierung nach Qt 4

sichergestellt, dass eine binärinkompatible Fensterdekoration nicht

geladen wird. Dieses domainspezifische Wissen haben die

Trinity-Entwickler verständlicherweise nicht.

Fazit

Gut gemeint ist nicht immer gut gemacht. Trinity mag gut gemeint

sein und enttäuschten Nutzern „ihr“ KDE 3.5 zurückgeben. Die

Illusion, dass Trinity KDE 3.5 am Leben erhalten kann, muss man den

Nutzern aber nehmen. Möchte Trinity nur den Desktop am Leben

erhalten, wird viel zu viel Code angefasst, was zwangsläufig zu

Fehlern führen wird. Zukunftssicher ist und kann Trinity mit der

aktuellen Manpower nicht sein.

Anwendern, die mit KDE Plasma nicht zurechtkommen, ist

wahrscheinlich eher mit einer anderen Desktopumgebung oder Distribution geholfen, die noch KDE 3.5 unterstützt

(z. B. Debian Lenny). Hierbei ist garantiert, dass zumindest

Sicherheitsupdates zur Verfügung gestellt werden und Funktionalität

nicht zerstört wird.

Links

[1] http://trinitydesktop.org/

[2] http://de.wikipedia.org/wiki/Abspaltung_(Softwareentwicklung)

[3] http://lists.kde.org/?l=kde-devel&m=125857018413079&w=2

[4] http://lists.kde.org/?l=kde-devel&m=125858829212077&w=2

[5] http://lists.kde.org/?l=kde-devel&m=125857983730550&w=2

[6] http://lists.kde.org/?l=kde-devel&m=125858816411879&w=2

[7] http://www.pro-linux.de/news/1/15731/trinity-projekt-fuehrt-kde-3-fort.html

[8] http://websvn.kde.org/branches/trinity/

[9] http://www.kde.org/announcements/announce-3.5.php

[10] http://dot.kde.org/2005/04/05/appeal-meeting-springtime-berlin

[11] http://conference2005.kde.org/sched-devconf.php

[12] http://aseigo.blogspot.com/2005/06/plasma.html

[13] http://www.freiesmagazin.de/freiesMagazin-2011-01

[14] http://aseigo.blogspot.com/2011/05/libplasma2.html

[15] http://trinitydesktop.org/about.php

[16] http://en.wikipedia.org/wiki/Jquery

[17] http://en.wikipedia.org/wiki/Autotools

[18] http://en.wikipedia.org/wiki/Cmake

[19] http://qt.nokia.com/about/news/archive/press.2007-01-22.4604809587/

[20] http://lists.debian.org/debian-devel/2011/05/msg00236.html

[21] http://en.wikipedia.org/wiki/HAL_(software)

[22] http://trinitydesktop.org/wiki/bin/view/Developers/RoadMap

[23] http://trinitydesktop.org/installation.php

[24] http://osdir.com/ml/release-team/2009-06/msg00048.html

[25] http://quality.kde.org)

[26] https://secure.wikimedia.org/wikipedia/de/wiki/Peer-Review

[27] http://reviewboard.kde.org/

[28] http://websvn.kde.org/?view=revision&revision=1172677

[29] http://websvn.kde.org/branches/trinity/kdebase/kwin/lib/kdecoration.h?r1=1172677&r2=1172676&pathrev=1172677

[30] http://websvn.kde.org/branches/trinity/kdebase/kwin/lib/kdecoration.h?r1=1212480&r2=1215552

| Autoreninformation |

| Martin Gräßlin (Webseite)

ist erst mit der 4.x Serie von KDE als Entwickler dazugestoßen und

heute Maintainer des Fenstermanagers KWin.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer

Basis aller Distributionen ist der Linux-Kernel, der fortwährend weiterentwickelt wird. Welche Geräte in einem halben Jahr unterstützt werden und welche Funktionen neu hinzukommen, erfährt man, wenn man den aktuellen Entwickler-Kernel im Auge behält.

Linux 3.1 veröffentlicht

Etwas mehr als zwei Wochen nach Freigabe des Kernels 3.0 präsentierte Torvalds die erste Vorabversion des Nachfolgers [1]. Es fand sich kein großer Wurf unter den eingebrachten Änderungen, womit sich bereits andeutet, dass 3.1 ähnlich seinem Vorgänger das Konzept des kleinen, stetigen Fortschritts weiterführt. Dennoch wurde kräftig an der Virtualisierungslösung KVM geschraubt, es gab auch Anpassungen an der Speicherschnittstelle iommu. Gerade im Treiber-Bereich kam einiges hinzu, zum Beispiel bei den Video-und DVB-Treibern, aber auch der Netzwerk-Teil erfuhr umfassende Änderungen. Am Treiber der GPIO-Schnittstelle (General Purpose Input/Output, Mehrzweck-Ein/Ausgabe) wurde scheinbar viel getan, tatsächlich wurden jedoch nur Dateien umbenannt, sodass ein großes Volumen an Änderungen zusammen kam.

3.1-rc2 [2] war noch weniger spektakulär, weshalb Torvalds gleich unterstellte, dass die Entwickler entweder faul oder im Urlaub seien. Immerhin gab es einen neuen Namen für den Kernel: „Wet Seal“ („nasse Robbe“). Der folgende -rc3 [3] passte ebenfalls in Torvalds Traum vom ruhigen Entwicklungszyklus, sodass er sich gleich dafür bei den Entwicklern bedankte – zu früh, wie sich zur vierten Vorabversion abzeichnete [4]: Waren die Änderungen an xfs noch überwiegend kosmetischer Natur, wurden hier fast alle Komponenten verschoben, was sich sehr stark auf die Zahl der geänderten Zeilen auswirkte. Daneben sehen die Änderungen zum Beispiel am wiimote-Treiber unscheinbar aus, sind mit über 250 geänderten Zeilen für einen -rc4 jedoch ein ganz schöner Batzen. Ähnlich sieht es auch beim target-Treiber aus, der Partitionen als iSCSI-Geräte im Netzwerk anbieten kann. Dabei wurde der wiimote-Treiber unter anderem an neue Gegebenheiten der Infrastruktur für Eingabegeräte angepasst und der iscsi-target-Treiber um verschiedene Funktionen erweitert und einige Fehler ausgemerzt. Doch obwohl notwendig oder zumindest sinnvoll, bringen solch große Änderungen immer die Gefahr mit, etwas kaputt zu machen und damit den Entwicklungsprozess zu verlängern. Mit -rc4 ging auch noch einmal eine Namensänderung einher. 3.1 heißt derzeit „Divemaster Edition“, ein Hinweis auf Torvalds Hobby.

Probleme mit 3.0

Schon auf kernel.org [5] ist nach der Änderung des Versionsnummern-Schemas noch nicht alles angepasst. Zwar werden die Änderungen der Patches der aktuell stabilen Reihe 3.0 mittlerweile dargestellt, für den Testing-Zweig 3.1 fehlt diese komfortable Funktion jedoch noch. Auch die Fedora-Entwickler befürchten Probleme und haben kurzerhand beschlossen, der nächsten Fedora-Version den Kernel 2.6.40 beizulegen – ein umbenannter 3.0-Kernel. Der Entwickler Dave Jones erwähnte, interessanterweise auf Google+ [6], dass eine Reihe von Änderungen an Userspace-Paketen notwendig wäre, wenn das neue Schema übernommen würde. Die von ihm befürchteten Gerüchte, dass Red Hat damit einen Fork des Linux-Kernels forcieren wolle, blieben jedoch aus. Die Diskussion glitt später etwas ab, als Torvalds um einen Fork von GNOME [7] bat, um weiterhin GNOME 2 anstatt Version 3 nutzen zu können [8].

Kernel mit Langzeit-Unterstützung

Mitte des Monats machte sich Greg Kroah-Hartman Gedanken darüber, wie Kernel-Versionen gehandhabt werden sollen, die über längere Zeiträume unterstützt werden [9]. Bislang wurden die sogenannten Longterm-Kernel mehr oder minder willkürlich gewählt, weil das eine oder andere Unternehmen wie zum Beispiel Novell, Kroah-Hartmans Arbeitgeber, darauf eine Enterprise-Distribution aufbaute. So kamen neben den mittlerweile fallen gelassenen 2.6.16 und .27 immerhin drei derzeit noch gepflegte Langzeit-Kernel zusammen (2.6.32, .34, .35 – kernel.org zeigt dies derzeit nicht korrekt an). Hier soll etwas mehr Struktur einkehren; so schlug Kroah-Hartman vor, künftig jedes Jahr einen Longterm-Kernel auszuwählen, der dann für zwei Jahre gepflegt wird. Die „normalen“ Kernel sollen wie gehabt unterstützt werden, bis der Nachfolger freigegeben wurde. Dies würde bedeuten, dass zu jeder Zeit zwei Longterm- und ein stabiler Kernel unterstützt werden, was deutlich überschaubarer wäre.

Einbruch auf kernel.org

Eher unerfreulich endete der August für die Kernel-Entwickler, als entdeckt wurde, dass in einen der Server von kernel.org eingebrochen worden war [10]. Die Einbrecher hatten root-Zugriff erlangt, Dateien des SSH-Servers verändert und einen Trojaner installiert. John Hawley, der Betreuer der kernel.org-Server, bemerkte es, als er die Ursache der Leistungsprobleme nachging. Es wird vermutet, dass die Angreifer über einen kompromittierten Benutzeraccount lokalen Zugriff erlangten. Wie sie sich danach root-Rechte verschafften, wird derzeit untersucht. Hawleys Ansicht nach blockiert der Entwickler-Kernel 3.1-rc2 jedoch den genutzten Exploit-Code. Derzeit werden auch alle Server von kernel.org neu installiert.

Der Entwickler Jonathan Corbet stellte heraus, dass der Kernel-Code innerhalb der Versionsverwaltung Git nicht verändert worden sei. Die Entwickler sind sich hierin sicher, da Architektur von Git jede Datei und jede Änderung mit einem Hash versieht, welcher die Integrität aller Inhalte gewährleistet. Änderungen wären den Entwicklern beim nächsten Abgleich mit kernel.org aufgefallen und wären dadurch entdeckt worden [11].

Links

[1] https://lkml.org/lkml/2011/8/7/102

[2] https://lkml.org/lkml/2011/8/14/281

[3] https://lkml.org/lkml/2011/8/22/333

[4] https://lkml.org/lkml/2011/8/29/8

[5] https://master.kernel.org/

[6] https://plus.google.com/106327083461132854143/posts/SbnL3KaVRtM

[7] http://www.gnome.org/

[8] http://www.pro-linux.de/news/1/17348/linus-torvalds-kritisiert-gnome-3.html

[9] http://www.kroah.com/log/linux/longterm-proposal-08-2011.html

[10] http://www.pro-linux.de/news/1/17448/einbruch-bei-kernelorg.html

[11] http://linux-foundation.org/weblogs/lwf/2011/08/31/the-cracking-of-kernelorg/

| Autoreninformation |

| Mathias Menzer (Webseite)

hält einen Blick auf die Entwicklung des Linux-Kernels. Dafür erfährt er frühzeitig Details über neue Treiber und interessante Funktionen.

|

| |

Diesen Artikel kommentieren

Zum Index

von Christian Imhorst

Es begann mit einem Irrtum. Im Werbebrief vom Google für den

AdWords-Dienst befand sich ein Gutschein über 75 Euro, der auf

einen völlig fremden Menschen ausgestellt war. Wenn man Sandra

Fründt, Head of Business Marketing Google Deutschland, auf ihren

Fehler aufmerksam machen will, immerhin hat sie diesen Brief

unterschrieben, stößt man auf ein Problem: Im Schreiben ist

überhaupt keine E-Mail-Adresse angegeben. Das Unternehmen, das mit

Suchmaschine und E-Mail-Dienst im Internet groß geworden ist, zeigt

sich in seiner Werbung ganz schön verschlossen.

Auf der Suche nach einer E-Mail-Adresse

Jetzt kann man sich eine mögliche und formal richtige E-Mail-Adresse

für die Empfängerin ausdenken, eine E-Mail an diese Adresse

schicken und darauf warten, ob der Mailserver die Nachricht auch

erfolgreich zustellen kann. Wenn er nämlich scheitert, bekommt man

eine Fehlermeldung als Antwort zurück. Entweder probiert man so

lange herum, bis diese Antwort ausbleibt, oder man kann, um das Ganze

abzukürzen, den Test auch in die Konsole verlagern. Das

Werkzeug für diesen Test ist das Telnet [1], für das bei den

meisten

GNU/Linux-Distributionen, MacOS X und sogar bei Windows ein Tool vorinstalliert oder schnell nachträglich zu installieren ist.

In der Vergangenheit war Telnet eine unverschlüsselte und daher

unsichere Methode für die Fernwartung von Rechnern. Der Vorteil von

Telnet ist aber, dass man sich über den entsprechenden Port mit so

ziemlich jedem Server verbinden kann, der ein textbasiertes

Protokoll beherrscht, also auch mit Mailservern. Diesen Vorteil

muss man allerdings mit Vorsicht genießen, da er auch von Spammern

genutzt wird.

Woher kommt das Wort „Spam“?

Die Bezeichnung „Spam“ für Massenmails zu Werbezwecken im Internet

wurde durch einen Sketch der englischen Komikertruppe

Monty Python geprägt. Der Sketch [2] spielt in einem

Imbiss, in dem es fast ausschließlich nur Spam (spiced ham), also

„gewürzten Schinken“, auf der Speisekarte gibt. Auf die Frage, ob

es auch etwas ohne Spam gäbe, antwortet die Kellnerin: „Well,

there's spam egg sausage and spam, that's not got much spam in

it.“ Woraufhin die Kundin sagt: „I don't want ANY spam!“. Später,

beim Versuch, etwas ohne Spam zu bestellen, kreischt sie sogar: „I

don't like spam!“ Spam wird in dem Sketch 132 mal genannt und steht

synonym für eine unnötig häufige Verwendung und Wiederholung.

|

Wie funktioniert E-Mail eigentlich?

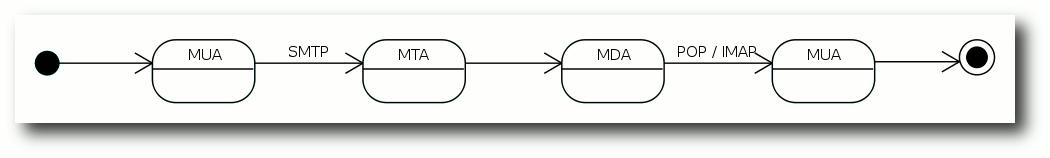

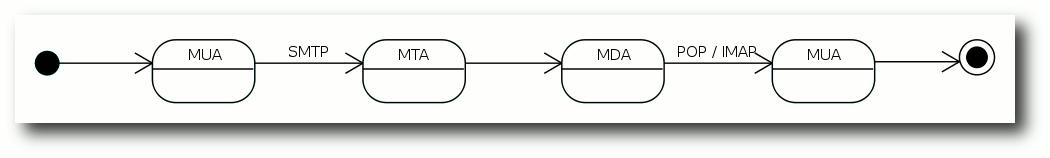

Bevor es losgeht, sollte man sich noch kurz klar darüber werden, was

beim Versenden von E-Mails überhaupt passiert und ein paar Begriffe

klären. In der Regel schreibt man eine E-Mail mit einem

E-Mail-Programm, das auch E-Mail-Client oder, etwas technischer,

„Mail User Agent“ (MUA) genannt wird. Traditionell werden die E-Mails

vom „Mail Transfer Agent“ (MTA), das ist dann der Mailserver,

entgegengenommen, falls nicht ein „Message Submission Agent“ (MSA)

dazwischen geschaltet ist, der die E-Mails vom MUA an den MTA

übergibt. Das Protokoll zum Versenden der Nachrichten zwischen

diesen Servern heißt „Simple Mail Transfer Protocol“ (SMTP). Auf der

Empfängerseite ist der „Mail Delivery Agent“ (MDA) verantwortlich für

die Zustellung

zum E-Mail-Client. Die Protokolle, die zum Abholen

von Nachrichten verwendet werden heißen „Post Office Protocol“ (POP)

oder „Internet Message Access Protocol“ (IMAP).

Der Weg einer E-Mail vom Sender zum Empfänger.

© Polluks (CC-BY-SA-3.0)

Nach der Theorie die Praxis

Normalerweise fragen Mailserver beim Versenden von E-Mails nach dem

vollständigen Namen

einer Domain. Da hier keine E-Mail verschickt

werden soll, wird mit dem Befehl nslookup nach dem entsprechenden

Domainnamen gesucht:

$ nslookup -q=mx google.com

Server: 192.168.178.1

Address: 192.168.178.1#53

Non-authoritative answer:

google.com mail exchanger = 50 alt4.aspmx.l.google.com.

google.com mail exchanger = 10 aspmx.l.google.com.

google.com mail exchanger = 20 alt1.aspmx.l.google.com.

google.com mail exchanger = 30 alt2.aspmx.l.google.com.

google.com mail exchanger = 40 alt3.aspmx.l.google.com.

Gesucht wird nach dem „Mail Exchange Resource Record“ (MX-Eintrag)

der Domain google.com im „Domain Name System“ (DNS), der sich

ausschließlich mit dem E-Mail-Dienst (SMTP) beschäftigt. Wie man

sieht hat Google gleich mehrere MX-Einträge mit unterschiedlichen

Prioritäten, damit bei einem Ausfall der jeweils andere die E-Mails

entgegen nehmen kann. Der Eintrag mit dem höchsten numerischen Wert

hat meist die niedrigste Priorität. Das nutzen Spammer gerne aus,

indem sie sich mit dem Mailserver mit der niedrigsten Priorität

verbinden, um Spamfilter zu umgehen, die auf dem Server mit der

höchsten Priorität laufen. Laut dem MX-Eintrag ist der Server mit

der höchsten Priorität aspmx.l.google.com. Mit dem wird jetzt die

Verbindung über Telnet und dem Port 25 für SMTP aufgebaut:

$ telnet aspmx.l.google.com 25

Trying 74.125.39.27...

Connected to aspmx.l.google.com.

Escape character is '^]'.

220 mx.google.com ESMTP 3si5028908fav.179

Was in diesem Fall bei Google klappt, kann bei anderen Mailservern

schon schief gehen. Zur Abwehr von Spammern lassen einige

Mailserver –

zum Beispiel von GMX – eine Verbindung zum Server im

MX-Eintrag gar nicht erst zu, wenn die Anfrage über die dynamische

IP eines Client-PCs gestellt wird und nicht von einem anderen

Mailserver kommt. Es kann aber auch sein, dass der Mailserver

aufgrund einer Störung einfach nicht erreichbar ist.

Was einem der Statuscode so sagt

Die letzte Zeile der obigen Ausgabe beginnt mit einer Zahl, nämlich

220. Im SMTP-Protokoll werden Befehle der Reihe nach ausgeführt und

jeder Befehl wird mit einem Statuscode beantwortet. Die

Beschreibung, die auf den Statuscode folgt, ist für Menschen

gedacht und für das Protokoll

ohne Bedeutung. Beginnt der

Statuscode so wie in diesem Fall mit einer 2, dann war die

Bearbeitung erfolgreich, bei einer 3 fehlen noch Informationen und

bei einer 5 ist ein Fehler aufgetreten.

Als erstes erwartet der Server eine Begrüßung in Form eines HELO,

dabei ist es im Prinzip völlig egal, welches Argument man nach dem

Befehl einträgt, auch wenn man eigentlich die eigene Domain angeben

sollte:

helo hi

250 mx.google.com at your service

Der Statuscode mit der 2 am Anfang zeigt, dass der Befehl

erfolgreich bearbeitet wurde und der Server zu Diensten steht.

Anschließend gibt man die E-Mail-Adresse des Absenders mit dem

Befehl MAIL FROM ein:

mail from: <test.user@googlemail.com>

250 2.1.0 OK 3si5028908fav.179

Die spitzen Klammern vor und nach der E-Mail-Adresse sind wichtig.

Ansonsten erhält man einen Syntax Error. Als nächstes gibt man

einen Empfänger ein, zum Beispiel eine Adresse von der man weiß,

dass sie existiert:

rcpt to: <larry.page@google.com>

250 2.1.5 OK 3si5028908fav.179

Gibt es die E-Mail-Adresse wirklich?

Die 250 oben verrät, dass der Befehl erfolgreich war. Die

E-Mail-Adresse scheint zu existieren. Doch auch hier gibt es die ein oder andere Falle, die Mailserver Spammern stellen.

Manche Mailserver haben ein Catch-All für E-Mails, dann laufen alle

E-Mails mit einer formal richtigen E-Mail-Adresse

der Domain in der

gleichen Mailbox zusammen und der Mailserver antwortet in diesem

Fall bei jeder formal gültigen Adresse mit einem „OK“.

Vielleicht wird auch eine Graue Liste zur Spambekämpfung

eingesetzt. Dabei wird die erste E-Mail von einem unbekannten

Absender abgewiesen und erst nach dem nächsten Zustellversuch

angenommen.

Eine weitere Methode ist das „Sender Policy Framework“ (SPF). Hier

schaut der empfangende Mailserver nach, ob die Domain im Befehl

MAIL FROM mit dem Argument des Befehls HELO übereinstimmt.

Wenn das nicht der Fall ist, kann es gut sein, dass der Rechner

E-Mails für diese Domain gar nicht versenden darf. Dadurch soll

das Fälschen von Absendern auf SMTP-Ebene erschwert werden.

Der nächste Versuch zeigt, dass der Mailserver von Google vermutlich

kein Catch-All verwendet:

rcpt to: <sandra.fruendt@google.com>

550-5.1.1 The email account that you tried to reach does not exist. Please try

550-5.1.1 double-checking the recipients email address for typos or

550-5.1.1 unnecessary spaces. Learn more at

550 5.1.1 http://mail.google.com/support/bin/answer.py?answer=6596 3si5028908fav.179

Auch ohne den Statuscode sieht man, dass hier etwas falsch läuft.

Die E-Mail-Adresse existiert laut dem Mailserver nicht. Das kann

auch wiederum mehrere Ursachen haben: Entweder ist Frau Fründt eine

Externe und gehört nicht zum Unternehmen oder es gibt dort mehr als

eine Sandra Fründt oder die Administratoren bei Google halten ein

einheitliches Namensschema für E-Mail-Adressen in einem Unternehmen

für überbewertet. Ein paar Versuche später wird klar, dass der

letzte Punkt zutrifft. Mit dem Befehl QUIT schließt man die

Telnet-Sitzung wieder.

Zum Validieren reicht es nicht

Am Ende konnte die – vermutlich – korrekte E-Mail-Adresse von Frau

Fründt zusammen mit den hier gesammelten Infos nur durch weiteres

Googeln genauer abgeglichen werden. Zur Validierung von

E-Mail-Adressen ist das Verfahren aus den oben genannten Gründen

somit nur begrenzt geeignet und wäre mit einem Webdienst wie

verify-email.org [3] wesentlich

schneller gegangen. Im Prinzip lässt sich so eigentlich nur

ermitteln, ob zum Zeitpunkt der Abfrage der Mailserver bereit oder

in der Lage ist, den Mailversand zu einer bestimmten E-Mail-Adresse

durchzuführen. Das kann für die

Fehlerdiagnose bei Versandproblemen

durch das Mailprogramm sehr hilfreich sein, indem man seinen

eigenen oder den Mailserver des Providers testet und dessen

Funktionsweise direkt in einer seiner Protokollsprachen SMTP, POP3

oder IMAP überprüft, aber auch zum Testen der eigenen Spamfilter.

Bonuslevel: Eine E-Mail über Telnet versenden

Eine E-Mail über Telnet zu versenden ist zwar etwas komplizierter,

kann sich aber zum Testen durchaus

lohnen [4]. Als Beispiel

dient hier der Maildienst von Google, wobei andere

E-Mail-Dienst-Anbieter ähnlich funktionieren sollten.

Das SMTP-Protokoll wurde aufgrund der zunehmenden Spamproblematik um

Verfahren zur Authentifizierung und Verschlüsselung

erweitert [5].

Um eine E-Mail zu verschicken, muss man häufig diese Erweiterungen

des Mailservers nutzen. Welche aktiv sind, findet man

mit dem Befehl EHLO heraus, der für „Enhanced HELO“ steht:

$ telnet smtp.googlemail.com 25

Trying 74.125.39.16...

Connected to googlemail-smtp.l.google.com.

Escape character is '^]'.

220 mx.google.com ESMTP d1sm327505fai.4

helo hi

250 mx.google.com at your service

ehlo hi

250-mx.google.com at your service, [89.182.218.152]

250-SIZE 35882577

250-8BITMIME

250-STARTTLS

250 ENHANCEDSTATUSCODES

Wie man an dem Beispiel gut sehen kann, schweigt sich der Befehl

HELO darüber aus, welche Fähigkeiten der Server bei

Verschlüsselung, Authentifizierung und so weiter besitzt. Die

bekommt man nur als Antwort auf EHLO. Die Ausgabe von STARTTLS

zeigt zum Beispiel, dass der Server Verschlüsselung unterstützt.

Codiertes Login

Aufgrund des vermehrten Spamaufkommens verlangen Mailserver

heutzutage eine Authentifizierung. Zur Vorbereitung der

Authentifizierung und weil man gleich sowieso eine verschlüsselte

Verbindung über openssl aufbauen muss, verlässt man den Server

jetzt mit dem Befehl QUIT.

Die Authentifizierung findet in einer Base64-Kodierung statt. Dazu

gibt man im Terminal den Befehl base64 ein und drückt „Enter“.

Anschließend folgt der Anmeldename, wieder gefolgt von „Enter“. Um

die Eingabe zu beenden, drückt man die Tasten „Strg“ + „D“ und erhält

in etwa folgendes Ergebnis:

$ base64

test.user@gmail.com

dGVzdC51c2VyQGdtYWlsLmNvbQo=

Das Passwort wird genauso mit Base64 kodiert. Wenn das erledigt ist,

baut man die verschlüsselte Verbindung zum Mailserver mit openssl

auf:

$ openssl s_client -starttls smtp -crlf -connect smtp.googlemail.com:25

Es folgt eine wirklich lange Ausgabe im Terminal, in der man unter

anderem sehen kann, dass Zertifikate ausgetauscht werden. Wenn

diese erste Hürde überwunden ist, begrüßt man den Server wieder mit

EHLO:

ehlo hi

250-mx.google.com at your service, [89.182.218.152]

250-SIZE 35882577

250-8BITMIME

250-AUTH LOGIN PLAIN XOAUTH

250 ENHANCEDSTATUSCODES

Nach der Begrüßung folgt das Login mit dem Befehl AUTH LOGIN und dem

Base64-kodierten Benutzernamen gleich dahinter:

auth login dGVzdC51c2VyQGdtYWlsLmNvbQo=

334 UGFzc3dvcmQ6

Der Statuscode 3 zeigt an, dass der Server noch weitere Infos

benötigt. Die Beschreibung, die einen darauf hinweisen soll, was

genau noch fehlt, ist übrigens auch Base64-kodiert:

$ base64 -d

UGFzc3dvcmQ6

Password:

Das heißt, man soll das Passwort eingeben, natürlich Base64-kodiert:

RGFzaXN0R2VoZWltCg==

235 2.7.0 Accepted

Sender und Empfänger

Nach der Eingabe des Base64-kodierten Passworts wird die E-Mail

geschrieben. Mit den Befehlen MAIL FROM und RCPT TO werden

Sender und Empfänger der E-Mail festgehalten:

mail from: <test.user@gmail.com >

250 2.1.0 OK l22sm324987fam.37

rcpt to: <empfaenger@beispiel.net>

250 2.1.5 OK l22sm324987fam.37

Wichtig ist, dass die E-Mail-Adressen in spitzen Klammern stehen.

Man kann RCPT TO auch mehrmals benutzen, wenn man die E-Mail an

weitere Empfänger versenden möchte.

Der Befehl DATA gibt an, dass jetzt die E-Mail folgt. Zu Beginn

gibt man der E-Mail beliebige Kopfzeilen mit, wobei Absender,

Empfänger und Betreffzeile hier am sinnvollsten sind. Welche

Adressen man in den Kopfzeilen einträgt, ist egal, es können ganz

andere sein, als die, die in den Befehlen MAIL FROM und RCPT TO

weiter oben eingetragen wurden. So einfach kann man Absender

fälschen.

data

354 Go ahead l22sm324987fam.37

From : Test <test.user@gmail.com>

To: Empfaenger <empfaenger@beispiel.net>

Subject: Hier kommt eine Testmail

Hallo Empfaenger,

hier kommt eine Testmail.

Viele Gruesse.

Wenn der Text fertig ist, beendet man den Befehl DATA mit einem

einzelnen Punkt in einer separaten Zeile. Nach der Bestätigung der

Eingabe durch den Mailserver ist die E-Mail verschickt und man

verlässt Telnet wieder über den Befehl QUIT.

Links

[1] http://de.wikipedia.org/wiki/Telnet

[2] http://www.youtube.com/watch?v=anwy2MPT5RE

[3] http://wiki.ubuntuusers.de/Mailserver_testen

[4] http://www.linux-magazin.de/Heft-Abo/Ausgaben/2002/04/Transport-Sicherung

| Autoreninformation |

| Christian Imhorst (Webseite)

hat bis heute keine Reaktion auf seine E-Mail an

Frau Fründt erhalten. Durch eine weitere Recherche mit Google hat

er mittlerweile auch ihre Handy-Nummer, die auf einer einsam

gelegenen Seite von Google selbst gleich neben ihrer Jobbezeichnung

und ihrer E-Mail-Adresse steht. Vielleicht schreibt er ihr mal eine

SMS, um nachzufragen, ob seine E-Mail auch wirklich bei ihr

angekommen ist, sobald er herausgefunden hat, wie man das über die

Kommandozeile macht.

|

| |

Diesen Artikel kommentieren

Zum Index

von Herbert Breunung

Während der vorige Teil dieses Tutoriums zu einer Hälfte aus

Vorbereitungen bestand und die andere Hälfte auf ein kleines

Programm hinarbeitete, wird dieses Mal nur noch programmiert. Dies

bedeutet aber nicht, dass wesentlich mehr Befehle auswendig zu

lernen sind, sondern dass der Student mehr von der Syntax begreifen

lernt: Was eigentlich ein Punkt oder Komma macht, wo man Klammern

setzt und was der Unterschied zwischen den runden und den geschweiften

Klammern ist.

Da „Syntax begreifen“ auch das Wissen umfasst, was wann angebracht

ist, wird damit begonnen, die Vor- und Nachteile von Alternativen

abzuwägen. Dazu gehört es auch, sein Programm stets fit zu halten.

Gerade weil das Projekt praxisnah stetig wächst, kann dabei gezeigt

werden, worauf man frühzeitig achten sollte, damit die Freude beim

Programmieren nicht vergeht.

Doch bevor die Lektion beginnt, würde vielleicht etwas Wiederholung

gut tun, es sei denn, alle der folgenden Befehle, Operatoren und

Zeichen können selbstständig und mit eigenen Worten erklärt werden:

use print say my our undef open read readline getc eof close chomp chdir

$ < > = ; #

Auch die erwähnten Pragmata und Module sollten nicht der

Vergessenheit anheimfallen:

strict warnings diagnostics utf8

FindBin File::Slurp IO::All

Wem dies nichts mehr sagt, sollte sich am besten noch einmal Teil 1

des Tutoriums aus freiesMagazin 08/2011 [1]

vornehmen.

Lösung der Aufgabe

Zur Festigung wurde letztes Mal aufgetragen, einen kleinen

Anfang des Notizprogramms zu schreiben. Deshalb heißt es jetzt:

„Editoren raus, Hausaufgabenkontrolle!“ Streng wird es jedoch

nicht, da die Aufgabe sich sehr vielfältig lösen lässt und nur die

eigene Zufriedenheit mit dem Programm zählt, das selbstverständlich

ohne Fehler oder Warnungen laufen sollte. Die kürzeste und klarste

Lösung ist wohl:

use v5.12;

use warnings;

use FindBin;

use File::Slurp;

chdir $FindBin::Bin;

say read_file('notizblock.txt');

print "Neue Notiz: ";

my $notiz = <STDIN>;

append_file

( 'notizblock.txt', $notiz );

use ist bereits bekannt. Das Programm verlangt mindestens Version

5.12.0, warnt auch vor möglichen Problemen. Weiterhin wird die

Information benötigt, in welchem Verzeichnis das Skript läuft,

für das das Modul FindBin benutzt wird. File::Slurp stellt die

Befehle read_file und append_file bereit, mit deren Hilfe Dateien

einfach gelesen und geschrieben werden können.

Als erstes macht chdir das Skriptverzeichnis zum

Arbeitsverzeichnis, damit die Datei mit den gespeicherten Notizen

gefunden werden kann. Diese liest read_file ein und say gibt

deren Inhalt sofort über das Terminal aus. print bringt die

Aufforderung, die nächste Notiz einzugeben. Die liest <STDIN>,

und das Gleichheitszeichen = legt sie in $nachricht ab.

append_file öffnet die Datei erneut am Dateiende und hängt die

Nachricht dort an.

Wer noch eine Notiz eingeben will, startet bn

(im letzten Tutorial angelegter Alias) noch einmal.

Dieses Programm war knapp, verständlich und eine sehr gute Lösung,

wäre die Benutzung von File::Slurp erlaubt. Denn wenn es einmal

komplizierter wird (einzelne Bytes auslesen) oder nicht die ganze

Datei benötigt wird, muss man auf open, read und close

zurückgreifen, was wenigstens einmal geübt werden sollte.

use v5.12;

use warnings;

use FindBin;

chdir $FindBin::Bin;

open my $FH, '+<',

'notizblock.txt';

say do { local $/; <$FH> };

print "Neue Notiz: ";

my $notiz = <STDIN>;

print $FH $notiz;

Der erste „Trick“ weshalb diese Fassung kaum länger ist: Die Datei

wird im Lese- und Schreibmodus (+<) geöffnet. Nachdem sie

vollständig gelesen wurde und der Zeiger mit der Lese- oder

Schreibposition am Ende der Datei steht, fügt jedes Schreiben

(letzte Zeile) etwas an. Die eigentliche Nuss steckt jedoch in

Zeile 8, die jetzt erklärt wird.

Blöcke und Spezialvariablen

Ein Paar geschweifte Klammern und die darin enthaltenen Befehle

(durch ein Semikolon ; getrennt) nennt man Block. Solche Blöcke

sind Programmteile, die nur bei Bedarf oder wiederholt

ausgeführt werden. Mit einem do vor dem Block wird dieser nur

einmalig und sofort abgearbeitet und das Ergebnis, meist das

Ergebnis des letzten Befehls im Block, kann genutzt werden.

Im Listing oben bekommt das do ein say zur Ausgabe. Die

eigentliche Magie passiert aber in dem Block. Variablen wie $/

werden tatsächlich oft als magisch bezeichnet, weil sie das

Verhalten von Perlbefehlen ändern und auch ihr etwas seltsames

Äußeres trägt zu dieser Bezeichnung bei. Statt $/ könnte man

genauso gut $INPUT_RECORD_SEPARATOR oder $RS schreiben, aber dazu

müsste man use English; zufügen. Das Modul English stellt, getreu

seinem Namen, den magischen Variablen

einen englischen Alias zur

Seite. Dazu sind jedoch viele Programmierer zu bequem oder sie

tolerieren die damit verbundenen Geschwindigkeitseinbußen nicht, die sich

allerdings mit use English '-no_match_vars'; umgehen lassen. Der

Kürze wegen verzichtet das Beispiel jedoch darauf.

<$FH> liest eine Zeile aus der geöffneten Datei. Doch woher weiß

Perl wo die Zeile endet? Am Zeichen, welches das Zeilenende

markiert. Da es nicht sichtbar ist, schreibt man \n (Das n

steht für „newline“, zu deutsch „neue Zeile“). Dieses \n ist

normalerweise der Inhalt von $/. Es wird von < > (readline)

benutzt und chomp entfernt immer nur die Zeichen, die sich in

$/ befinden. In dem kleinen Block wird $/ entleert, sodass < >,

ohne ein Zeilenende erkennend, die gesamte Datei bis ans eof

(Dateiende) einliest.

Um andere < >-Operationen nicht zu

beeinflussen, sollte diese Änderung von $/ nur in diesem Block

wirksam sein. Alle Spezialvariablen sind nämlich von Hause aus

global, d. h. im gesamten Perl-Slript bekannt. Um dies einzuschränken

ist das Wort local da. Es ist der weniger strenge Vorläufer von

my (genaueres dazu folgt in einem späteren Tutorium),

der $/ bis zum Ende des Blocks mit einem anderen Wert

(undef da nichts zugewiesen) überschreibt.

Magische Variablen haben meist recht logische Namen (perldoc

perlvar hilft), ihre Form gibt fast immer einen Hinweis auf ihre

Bedeutung. Der Schrägstrich (Slash) in $/ deutet eine geöffnete

Klappe an, in die sich etwas von oben hineinschütten lässt.

Die Benutzung

der Spezialvariablen, sollte jedoch auf ein Minimum beschränkt

werden und in Produktivcode sind die Kurzformen gänzlich zu

vermeiden.

Kontext

Doch auch das aktuelle Programm kann verbessert werden. $nachricht

wird nur einmal gefüllt und gleich danach nur einmal gebraucht.

Könnte man nicht auch print $FH <STDIN>; schreiben? Beinahe, es

müsste richtig lauten:

print $FH scalar <STDIN>;

Was scalar tut, könnte manchen dämmern, da bereits

bekannt ist, was skalare Variablen sind. Deutschlehrer sagen

Singular dazu, das Gegenteil von Plural (Mehrzahl). Es beschreibt

nämlich, dass <STDIN> nur einen Wert liefern soll. Würde man es

weglassen, passierte etwas ungemein Heimtückisches. print

erwartet eine Mehrzahl an Werten, die es hintereinander ausgibt.

Das folgende < > bekommt das mit und erfüllt diese Forderung

gerne. Ungünstig ist nur, dass der Begriff „Mehrzahl“ kein Ende

definiert. Der Nutzer würde eine Notiz nach der anderen eingeben,

ohne jemals weiter zu kommen. Was an dieser Stelle nach böser Falle

aussieht, ist sonst eine Quelle von Perls großer Macht. Das Prinzip

nennt sich Kontext oder auch Kontextsensitivität und bedeutet, dass

einzelne Befehle den Ton angeben (den Kontext bestimmen) und der

Rest versucht seine Ergebnisse anzupassen. Wegen dieses Prinzips

konnte ein Plus (+) seine Summanden in Zahlen umwandeln lassen.

Automatisches close

Weil Perl so viel Freiheit und integrierte Intelligenz bereitstellt,

fordert es den Programmierer auf, seine Absicht genau auszudrücken.

Das vorgestellte Beispiel war auf Kürze optimiert und jeder fähige

Coder versteht es auch. Aber größere Programme sollten vor allem

robust sein. Damit ist gemeint, dass man es leicht ändern kann,

ohne dass sofort das halbe Programm aufhört zu arbeiten. Das heißt

manchmal auf clevere Kniffe zu verzichten und in diesem Fall das

close $FH; dazu zu schreiben, auch wenn das Dateihandle

automatisch am Ende geschlossen wird.

Was gute Programmierer auch ausmacht: Sie planen jede Möglichkeit

ein. Wenn keine notizblock.txt vorhanden ist, dann wirft das

bisherige Programm:

readline() on closed filehandle $FH at bn.pl line 8

Das war zwar nur eine Warnung (kein Abbruch) aber der Rest des

Programms funktioniert nicht. Willkommen im Alltag! Das

Handle in $FH wurde für „zuerst lesen, dann schreiben“

initialisiert. Aus einer nicht vorhandenen Datei kann nichts

gelesen werden. Daher die Fehlermeldung. Und da nichts gelesen

wurde, kann später auch nicht mit dem Handle geschrieben werden

(zweite Meldung).

Menschen, die schon etwas Perl kennen, schreiben deshalb so etwas wie:

open( ... ) or die "Keine notizblock.txt vorhanden";

Selbst wenn man nicht weiß, was genau das logische Oder (or)

macht, kann man es sich doch denken, denn es liest sich wie ein

(englischer) Satz: „Öffne die Datei oder stirb.“ Genau das tut es

auch, wobei die einfach ein anderer Name für print STDERR

"Nachricht", verbunden mit dem Programmabbruch, ist.

STDERR ist das Handle der Standardfehlerausgabe. Meist ist

daran ebenfalls die Shell gebunden wie bei STDIN und STDOUT. In

letzter Zeit hat es sich aber durchgesetzt use autodie; zu

schreiben. Durch dieses Pragma sterben die Programme automatisch,

wenn Befehle wie open Probleme haben, und die dabei entstehenden

Fehlermeldungen sind weit informativer als das, was sich

Programmierer meist einfallen lassen. Da „Gib ein Bier oder stirb!“

der einzige Weg ist, in einer klingonischen Bar seinen Durst zu

löschen, bekam autodie den Beinamen des klingonischen

Programmierstils.

Weil ein Tod nur hilft, einen Konflikt schneller zu erkennen, ihn

aber nicht löst, wäre es besser, mit einem Handle anhängend auf die

Datei zuzugreifen und das Handle mit dem nächsten Befehl wieder zu

schließen. Dies verändert die Datei nicht, würde im Falle der

Nichtexistenz aber eine leere Datei anlegen. Sicherlich täte der

aus Perl einfach aufrufbare Unix-Befehl touch dasselbe,

aber die Anwendung

soll ja auch unter Windows laufen.

{ open my $FH, '>>',

'notizblock.txt' }

Der Befehl im Block wird normal ausgeführt. Ohne do verzichtet man

einzig auf das Ergebnis von open. Nur die Variable $FH wird

wegen des my mit der schließenden Klammer gelöscht, als wenn es

sie nie gegeben hätte. Davor wird mit dem darin enthaltenen Handle

ein close ausgeführt. Gäbe es noch eine zweite Variable $FH vor

der öffnenden Klammer, sie wäre von all dem unberührt. Lediglich ab

dem my $FH lässt sich im inneren Block mit $FH einzig auf die

neue, „innere“ Variable zugreifen.

Guter, trockener Code

Erfahrene Programmierer hätten vielleicht ein Problem damit, dass

der Dateiname zweimal auftaucht. Sie würden den Dateinamen am

Programmanfang in eine Variable geben und diese anstatt des Names

verwenden.

...

my $datei = 'notizblock.txt';

chdir $FindBin::Bin;

{ open my $FH, '>>', $datei; }

open my $FH, '+<', $datei;

...

Das mag etwas übertrieben wirken, hat aber drei wichtige Gründe:

- Man sollte Dopplungen vermeiden, wo es geht. Durch das Befolgen

des DRY-Prinzips („dry“ heißt auf deutsch „trocken“ und steht für

„don't repeat yourself“) werden

Programme wesentlich leichter änderbar. Sollen die Notizen später

in einer anderen Datei gespeichert werden, braucht der Autor nur

eine Stelle ändern anstatt zwei.

- Der Autor muss die Stelle nicht suchen, da sie am Anfang ist.

- Gute Variablennamen machen den Quellcode verständlicher

als zufällige Daten im Code.

In diesem Beispiel ist der Unterschied nicht so wesentlich, aber es

ist entscheidend, frühzeitig dafür ein Auge zu entwickeln. Die

wahre Ursache, warum es Programme gibt, die eher an ein Haarknäuel

im Ausguss erinnern, ist nicht die Wahl der Sprache. Sie entstehen,

wenn jemand seine Werkzeuge und vor allem die logische Struktur der

Aufgabe nicht versteht. Meist gewinnt man das Verständnis in allen

Feinheiten aber erst während des Programmierens, weshalb es für den

Erfolg wesentlich ist, Gebilde aufzubauen, die sich leicht ändern

lassen.

Bedingte Ausführung und Dateitests

Optimal wäre es, den kleinen Block mit dem open nur dann

auszuführen, wenn die Datei wirklich fehlt. Der dafür zu

gebrauchende Befehl lautet in fast allen Sprachen if („wenn“).

Dem folgt die Bedingung in runden Klammern. Wird die Bedingung als

„wahr“ ausgewertet (Ergebnis nicht leer, 0 oder undef) wird der

darauf folgende Block ausgeführt. Perl kennt auch noch ein

unless, das den Block ausführen lässt, wenn die Bedingung

„unwahr“ ist.

Das Prüfen, ob die Datei vorhanden ist, geht in Perl sehr einfach.

Dazu gibt es die Dateitestoperatoren, welche sich am

Unix-Kommandozeilenprogramm test orientieren und mit einem Minus

- beginnen. Die Prüfungen orientieren sich meist am ersten

Buchstaben dessen, was geprüft wird. Auf die Existenz der Datei wird im

Beispiel mit dem Operator -e getestet:

unless (-e $datei)

{ open my $FH, '>>', $datei; }

Wenn der Block nur einen Befehl enthält, kann man auch eine andere

Schreibweise wählen. Die nennt sich „nachgestellt“, weil hier das if

oder unless nach dem Befehl steht:

open my $DH, '>>', $datei unless -e $datei;

Dabei lassen sich nicht nur die geschweiften, sondern auch die

runden Klammern um die Bedingung weglassen. Einen Unterschied gibt

es nur für die Variable, die jetzt einen größeren Geltungsbereich

hat.

Der Aufruf open ist nicht mehr in einem Block { }

eingeschlossen. Deshalb muss das my im folgenden Befehl entfernt

werden, da deren Geltungsbereich schon bestimmt wurde. Oder man

wählt zwei verschiedene Variablennamen.

Sowohl das zweimalige Öffnen einer Datei mit einem Handle, als auch

das Öffnen einer Datei mit zwei Handle ist in Perl vorgesehen. Mit

seek lässt sich sogar die aktuelle Lese- und Schreibposition

versetzen, die tell $handle; einem mitteilt. Mehr dazu sagt die

perldoc, wenn sie gefragt wird (Erklärung einer function – eines

Perl-Befehls):

$ perldoc -f seek

$ # Dokumentation fuer ein Modul

$ perldoc File::Slurp

$ # unter Unix geht das auch

$ man File::Slurp

In den nächsten Abschnitten wird wieder File::Slurp verwendet. Es

macht das Programm klarer und reicht vom Funktionsumfang bis

mindestens Teil 4 dieses Tutoriums völlig aus, da jede Nachricht

eine Zeile belegt. Weil Enter die Eingabe abschließt, können die

Zeilenumbrüche nur am Ende jeder Notiz stehen. Dann muss man die

Zeilenabbrüche \n auch nicht mit chomp entfernen, sondern kann

sie gleich mit speichern.

Die üblichen Vergleiche

Sobald das Programm zwei-, dreimal verwendet wurde fällt auf, dass

eine Nachricht bei jedem Aufruf eingegeben werden muss. Oft dient

ein Notizblock jedoch nur der Erinnerung. Deshalb sollte man die

Eingabe abbrechen können, sodass nichts gespeichert wird.

say read_file($datei) if -e $datei;

print "Neue Notiz: ";

my $notiz = <STDIN>;

append_file($datei, $notiz)

if $notiz ne "\n";

Um Texte zu vergleichen, nimmt man die Operatoren eq (kurz für

„equal“, d. h. „gleich“) oder ne („not equal“ – „ungleich“). Die

letzte Zeile liest sich somit wie ein englischer Satz: „Füge an die

$datei die $notiz, wenn die $notiz nicht nur aus dem

Zeilenende besteht“. Mögliche Alternativen wären auch unless

$notiz eq "\n" oder if not $notiz eq

"\n" (das Wörtchen not verneint eine Aussage).

So wie das Plus (+) erwartete (erzwang), dass beide Operanden (die

Werte links und rechts) Zahlen sind, so erzwingen die Operatoren

eq und ne den Stringkontext (Text). Es gilt die Faustregel:

Sind es Symbole oder Formelzeichen, geht es um Zahlen; besteht der

Operator aus Buchstaben, geht es auch um Buchstaben. Zahlen

vergleich man mit == und da <> anderweitig im Gebrauch ist, wird

Ungleichheit mit != geprüft. Das ist insoweit logisch, da ein

Ausrufezeichen ! fast immer das Gegenteil ausdrückt (wie not auch).

Die Regel befolgend beziehen sich <, <=, >, >= nur auf

Zahlen. Wörter lassen sich alphabetisch sortieren. < prüft ja nur

ob zum Beispiel die 3 vor der 4 am Zahlenstrahl steht. Da dem so

ist, gibt 3 < 4 oder "3" < "4" einen positiven Wert (meist 1).

Auf Englisch spricht man das < „lower than“ aus. Deswegen ist lt

identisch zu <, nur auf Text bezogen: 'a' lt 'b' ist auch wahr.

Dies lässt sich jetzt analog fortführen: „lower equal“ (kleiner

gleich) wird zu le, „greater than“ zu gt, „greater equal“ zu

ge. perldoc perlcheat zeigt einen Spickzettel, auf dem solche

Dinge übersichtlich zusammengefasst sind. Den dort auf ge

folgenden, sehr nützlichen Raumschiffoperator für Vergleiche

erklärt der nächste Teil.

Zahlen

Zahlen müssen nicht in Anführungszeichen gestellt werden, da Perl

auch ohne sie ermittelt, wo sie anfangen und aufhören. Sie bestehen

ja lediglich aus den zehn Ziffern und ein wenig mehr. Es könnte ein

Minuszeichen davor stehen. Wobei das - auch als Operator negieren

kann, also - 5 und -5 ergeben das Gleiche. Der Punkt ist das

Komma für gebrochene Zahlen, da Kommata in Perl (und vielen anderen

Sprachen) für Aufzählungen von Werten (Listen) da sind. Aber Obacht,

der Punkt ist auch der Operator der Zeichenketten verbindet:

'der ' . 'Hirsch' # entspricht 'der Hirsch'

4 . 5 # '45', Verkettung von Text

4 .5 # '45', auch hier ist .

# Stringoperator

4. 5 # Fehler

4.5 # 4,5

4.0 . 's' # '4s'

Zahlen dürfen Unterstriche enthalten (1_000_000). Perl ignoriert

sie, weil sie nur der Lesbarkeit dienen. Wie bei Taschenrechnern

schreibt sich die Million auch als 1e6, weil es 1 mal 10 hoch 6

ist (1*10**6). Wer in Mathe aufgepasst hat, weiß jetzt auch, dass

ein Hundertstel identisch zu 1E-2 sind. Das e steht für

„Exponent“ und darf klein oder groß geschrieben werden.

4 == 4.0 # wahr, denn 4 ist 4

4 eq 4.0 # wahr, weil 4.0 zu 4,

# dann '4' wird

4 eq '4.0' # falsch, weil '4' und

# '4.0' nicht der selbe Text ist

Da Rechner keine 10 Finger haben, können sie nur bis 1 zählen und

rechnen deswegen mit 0 und 1. Für sie ist eine Million

0b11110100001001000000. Beginnt in Perl eine Ziffernfolge mit 0

(Null) ist das ein Signal: Achtung, die Zahl ist nicht dekadisch

kodiert (Zehnersystem wie in der Schule) sondern oktal. In diesem

System kommt nach der 7 die 10 (Zählwert 8), weil die Ziffern nur

bis 7 gehen. 0b (Null und klein b) ist der Vorsatz für binäre

Zahlen (zwei Ziffern) und 0x der für hexadezimale Zahlen .

Textangaben

Im letzten Beispiel war es sehr wichtig, doppelte Anführungszeichen

um "\n" zu legen. damit die spezielle Notation \n als

Zeilenumbruch interpretiert werden kann. Neben doppelten

Anführungszeichen gibt es auch noch einfache Anführungszeichen

(Hochkommata). Diese einfachen Anführungszeichen nehmen alles

wörtlich, was zwischen ihnen steht, es gibt aber zwei Ausnahmen. Um

auch mal ein Hochkomma im Text vorkommen zu lassen, wird ihm ein

Backslash \ vorangestellt. Das nennt man „escapen“ [2]. Auf deutsch: Das Zeichen

wird durch ein zusätzliches Zeichen seiner sonstigen Bedeutung

enthoben.

say 'hab\'s kapiert';

In der Shell erscheint hab's kapiert. Aber wie schafft man es,

wenn in einem Tutorium zeichengetreu hab\'s kapiert zur

Anschauung ausgegeben werden soll? Dann wird das Escape-Zeichen wiederum

„escaped“:

say 'hab\\\'s kapiert';

Die doppelten Anführungszeichen können (wie es ihre Form andeutet)

wesentlich mehr. In ihnen werden \n und die anderen

Escape-Sequenzen gegen unsichtbare Steuerzeichen ausgetauscht und

auch Variablen, die man dort einfügt, werden durch ihren Inhalt

ersetzt. Evaluieren heißt das in der Fachsprache.

Neben “ und gibt es noch die Backticks ``. Was in sie

gestellt ist, wird sofort ausgeführt (wie in der Shell, deren

Ausgabe (STDOUT) das Ergebnis ist). Das war vorhin mit der Aussage

„touch ausführen“ gemeint. Backticks interpretieren ebenfalls

Variablennamen und Steuerzeichennotationen wie \n ähnlich den

doppelten Anführungszeichen. „Quoten“ (in Anführungszeichen oder

Ähnliches setzen) ist in Perl ein breites Feld, über das noch

berichtet wird. Als Grundlage reicht das hier vermittelte Wissen

jedoch erst einmal.

Arrays

Zurück zum Notizprogramm. Endlich ist es solide, aber der

Funktionsumfang ist noch dünn. Was jetzt am dringendsten fehlt, ist

eine Möglichkeit, Nachrichten zu löschen. Am besten einzeln

natürlich. Später könnte man noch die Reihenfolge ändern. Dazu

müsste man jede Zeile in eine andere Variable geben ($notiz1, $

notiz2, usw.), aber eigentlich gehören diese ganzen Variablen

zusammen. Beim Speichern in die Datei lässt sich auf dem Weg kaum

bestimmen, welche Variablen dazugehören. Die ganze Liste an Notizen

sollte am besten in einer Variable deponiert sein. Dann fragt man

nur nach dem Wert Nummer 1, dem letzten oder allen Werten.

So geht es auch, nur dass Arrays bei 0 anfangen zu zählen (wie dieses

Tutorium), also das Feld Nummer 1 den zweiten Wert enthält.

Array-Variablen beginnen mit der Sigil @ („at“ genannt; das „a“

steht für Array). So lassen sie sich leicht unterscheiden und man

kann @notiz und $notiz haben.

Larry Wall sieht das $ als Zeichen für Einzahl und @ als Zeichen

für Mehrzahl an, so wie im deutschen die Endung „en“. Wenn man das

weiß, wird auch klar, wieso man $notiz[0] schreiben muss, wenn man

die erste Nachricht aus @notiz haben will und wieder

@notiz[0,1] wenn die erste und zweite Nachricht interessiert.

Das Füttern der Arrays ist denkbar einfach:

my @ziffern = (0, 1, 2, 3, 4, 5, 6, 7, 8, 9);

my @ziffern = (0 .. 9); # das Gleiche kuerzer

# dank dem Rangeoperator ..

my @farben = ('rot', 'blau', 'gruen', 'gelb');

my @farben = qw(rot blau gruen gelb); # kuerzer

Runde Klammern umfassen ein Array, auch das Array an Werten, die

einem Befehl gegeben werden. Dort kann man sie aber oft weglassen,

und sie werden nur geschrieben, um klar zu stellen, wo das Array

endet. qw („quote words“, setze von Leerzeichen oder Tabulatoren